Cosa ho imparato alla conferenza di Ginevra sull’Intelligenza Artificiale

Il 6 e 7 luglio si è tenuta la conferenza internazionale AI for Good dove alcuni tra i più grandi pensatori contemporanei hanno conversato sui due temi a mio avviso più importanti della nostra era: l’intelligenza artificiale con i suoi impatti e gli obiettivi di sviluppo sostenibile dell’ONU. Unire questi due mondi è una necessità: l’AI è il principale strumento che abbiamo per salvare il nostro pianeta.

“AI for Good” è una piattaforma digitale globale delle Nazioni Unite che opera tutto l’anno. Questa piattaforma consente agli innovatori dell’intelligenza artificiale (AI) e ai responsabili delle decisioni di imparare, discutere e collaborare per sviluppare soluzioni AI concrete che promuovono gli Obiettivi di Sviluppo Sostenibile (SDGs) delle Nazioni Unite. Dopo una pausa dovuta al Covid, quest’anno la conferenza si è svolta il 6 e 7 luglio presso il CICG (International Conference Center Geneva). La necessità di organizzare vertici globali incentrati sull’azione nell’ambito dell’AI è nata dalla constatazione che il dibattito accademico era dominato da ricerche specifiche, come il Netflix Prize per migliorare l’algoritmo di raccomandazione di film. Durante la conferenza di quest’anno, uno degli oratori ha sfidato l’audience con una domanda provocatoria: “Crediamo veramente che il massimo potenziale dell’AI sia fornire annunci pubblicitari su cui le persone cliccano di più?”.

AI for Good si dedica a promuovere ricerche sull’intelligenza artificiale che possono contribuire alla risoluzione di problemi globali, in particolare nel contesto degli Obiettivi di Sviluppo Sostenibile. Questa iniziativa è gestita dall’ITU (Unione Internazionale delle Telecomunicazioni), un’agenzia delle Nazioni Unite specializzata nelle tecnologie dell’informazione e della comunicazione.

L’ITU, istituita nel 1865, afferma sul suo sito web che “Ogni volta che fai una chiamata tramite il cellulare, accedi a Internet o invii un’email, stai beneficiando del lavoro dell’ITU […] L’ITU si impegna a connettere tutte le persone del mondo – ovunque vivano e qualunque siano i loro mezzi. Attraverso il nostro lavoro, proteggiamo e sosteniamo il diritto di comunicare di tutti.” Di conseguenza, è del tutto logico che l’ITU promuova la creazione di un sistema di governance globale per l’Intelligenza Artificiale, che rappresenta attualmente la tecnologia informatica e di comunicazione più avanzata a nostra disposizione.

Quali erano le mie aspettative su AI for Good 2023?

Mi aspettavo fondamentalmente di poter esplorare lo stato avanzato dell’AI e di avere l’opportunità di apprendere direttamente dalle figure più influenti in questo campo. Ero inoltre interessato a capire come l’Intelligenza Artificiale possa influenzare positivamente il nostro mondo, argomento cruciale per l’azienda – Arkage – che ho l’onore di guidare attraverso un’era di potenti cambiamenti.

La mia prima impressione dell’evento è stata sorprendente: robot, robot e ancora robot, ovunque. Dalla ormai celebre Sophia ad altri robot antropomorfi estremamente avanzati, fino a robot di salvataggio, bracci meccanici, droni, quadrupedi saltellanti e piccoli cingolati. La hall del centro congressi ospitava stand di diverse aziende partner dell’iniziativa e palchi per sessioni secondarie che trattavano temi più tecnici – sicuramente di grande interesse per i professionisti del settore. Ma per me, filosofo di formazione, il clou era costituito dall’auditorium con il palco principale. Sono riuscito a raggiungerlo giusto in tempo per l’inizio dell’evento, dopo aver schivato un’avanzatissima foca-robot da compagnia.

La conferenza si è svolta nell’arco di due giorni: il primo giorno ha avuto un carattere più istituzionale, con il discorso d’apertura tenuto dal segretario generale delle Nazioni Unite, mentre il secondo giorno ha visto una maggiore focalizzazione su questioni di governance e sul futuro dell’Intelligenza Artificiale.

AI for Good 2023 – Primo giorno

L’anteprima della conferenza è stata spettacolare: l’artista Harry Yeff ha meravigliato il pubblico con la sua “machine inspired voice”. È qualcosa che dovreste ascoltare voi stessi, poiché è impossibile descriverlo a parole.

1° insight: gli artisti hanno una relazione con l’innovazione più intima delle altre persone che hanno a che fare con l’AI.

L’elemento artistico ha acquisito una posizione centrale nell’evento, raggiungendo il suo apice in un panel del secondo giorno, anche grazie allo splendido lavoro della presentatrice LJ Rich, artista AI lei stessa.

In questo clima di fervore artistico, António Guterres, Segretario Generale dell’ONU, ha saputo riportare l’audience alla realtà, sottolineando la necessità di utilizzare il potere dell’AI per accelerare la transizione verso i 17 SDGs (gli obiettivi di sviluppo sostenibile da raggiungere entro il 2030). Ha evidenziato l’importanza di stabilire delle linee guida che impediscano a questa tecnologia di deviare dal suo percorso verso il ‘bene’.

La cooperazione internazionale è sempre stata al centro della conferenza – evidentemente Ginevra è la location perfetta per questo tipo di approccio – e ciò lo ha ribadito anche Doreen Bogdan-Martin, Segretaria Generale dell’ITU. Proprio attraverso l’impegno congiunto di tutti i Paesi membri dell’ONU, l’AI può essere utilizzata per rimettere in pista l’Agenda 2030.

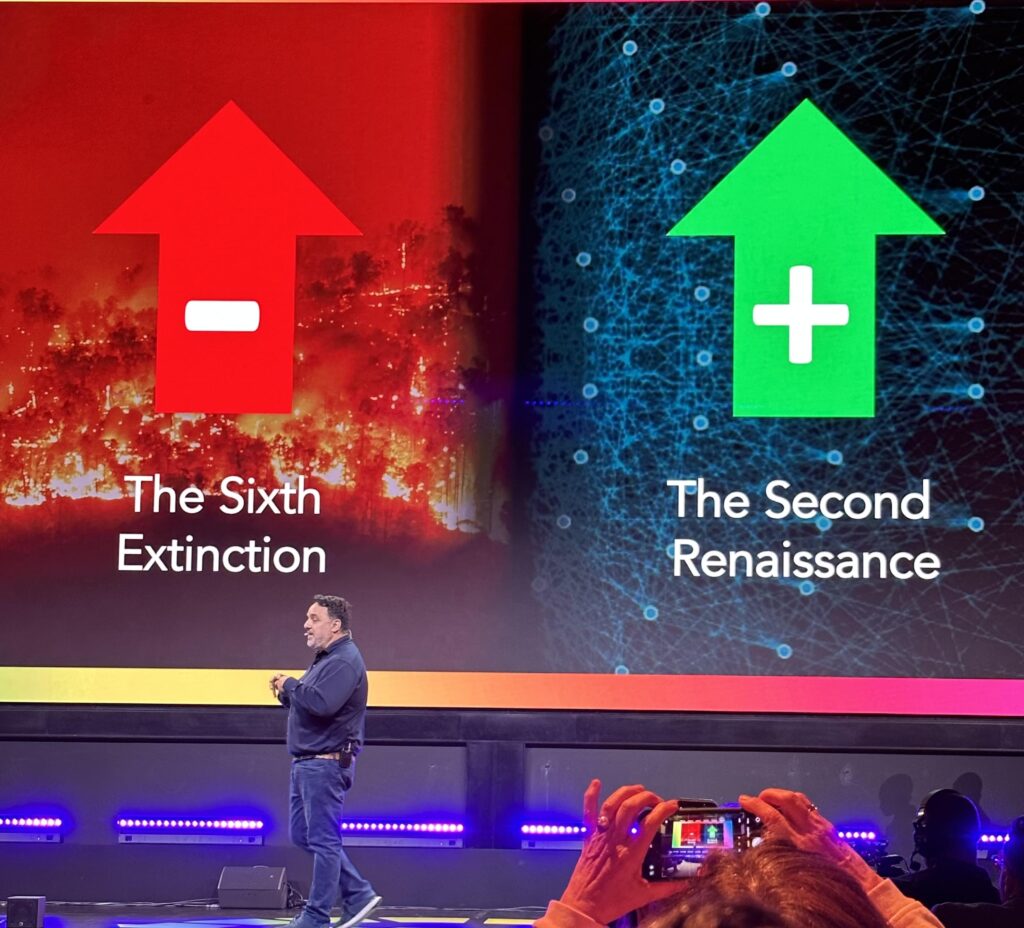

Secondo Bogdan-Martin, esistono tre scenari futuri possibili:

- Un uso improprio dell’AI che causerà l’insuccesso degli SDG e potenzialmente conseguenze ancora peggiori;

- Un uso non regolamentato dell’AI che accentuerà le disparità tra le nazioni e le disuguaglianze tra coloro che hanno moltissimo (potere, denaro, opportunità) e chi non ha nulla;

- Il successo nel raggiungimento degli obiettivi SDG grazie anche all’implementazione dell’AI.

2° insight: l’AI è il super potere che ci permetterà di accelerare verso il raggiungimento degli SDG.

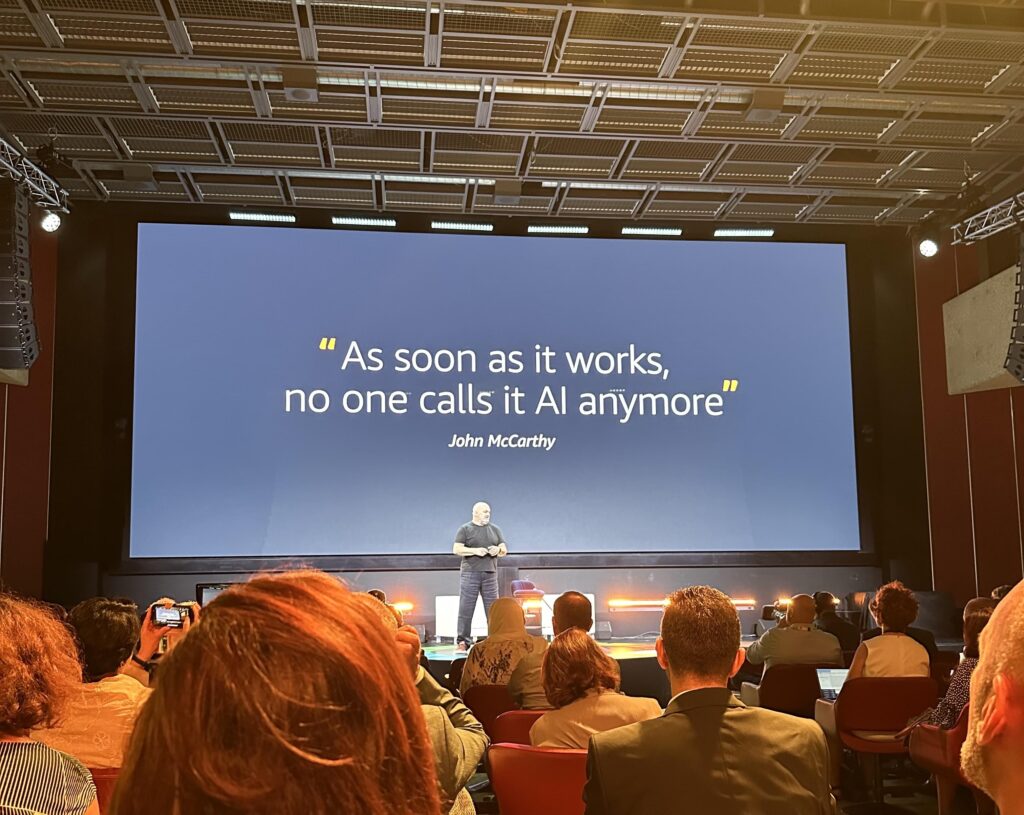

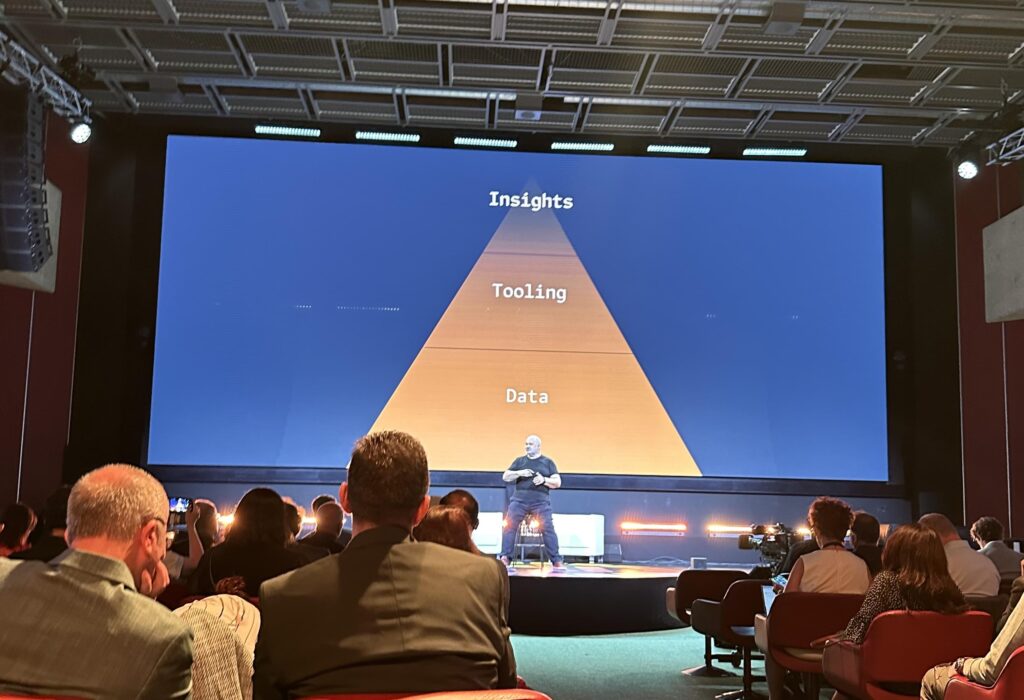

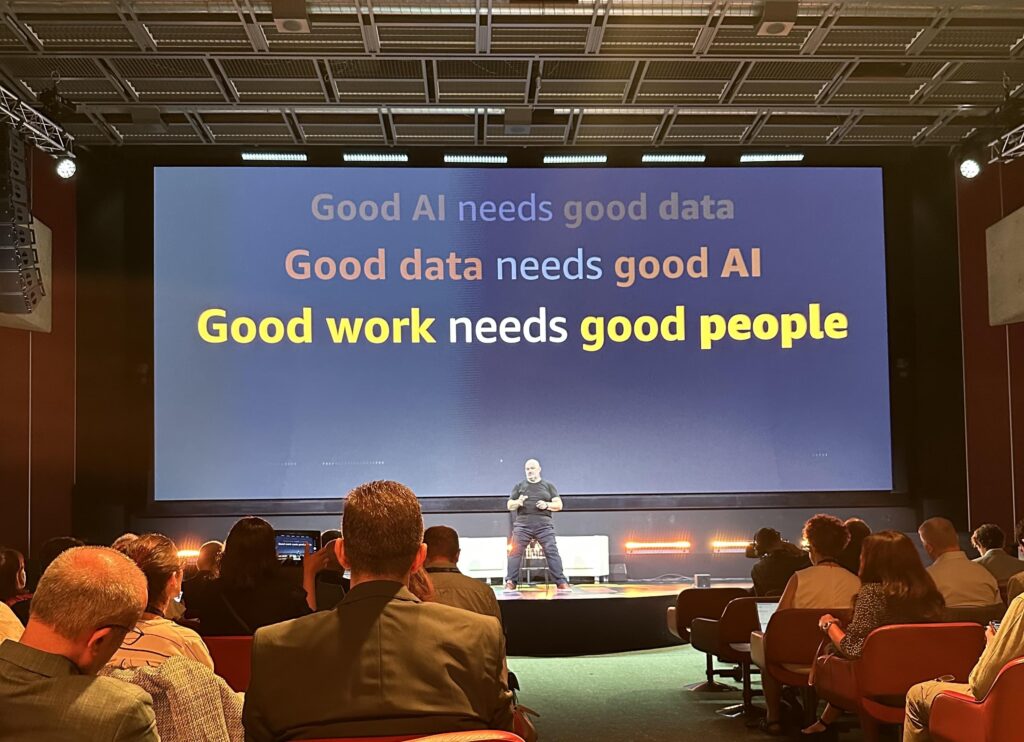

Ma cosa significa concretamente avere successo nell’utilizzo dell’AI? Numerosi esempi provengono dalla serie “Now Go Build” (disponibile su Amazon Prime) che presenta casi di successo in tutto il mondo. Il protagonista della serie, Werner Vogels, CTO di Amazon, ha preso parte alla conferenza pur con l’aiuto di una stampella, giustificandosi per avere un ginocchio artificiale, reso possibile dai progressi tecnologici. La tecnologia, e in particolare l’AI, può davvero fungere da acceleratore verso gli SDG, a patto che le macchine si limitino a fare previsioni e che sia l’umanità a prendere le decisioni. Perché ciò si realizzi, è fondamentale disporre di una grande quantità di dati, che rappresentano le basi per tutte le AI. Quindi, l’obiettivo è democratizzare l’accesso ai dati, rendendo l’AI lo strumento che ci consentirà di ottenere approfondimenti preziosi.

Quello che mi ha piacevolmente sorpreso di questa conferenza è stata l’ampia presenza femminile, in un campo – quello dell’AI – tradizionalmente dominato dagli uomini, come ha sottolineato Lila Ibrahim di Google Deepmind. Salendo sul palco dopo Werner, ha enfatizzato l’importanza di stabilire principi che permettano all’AI di beneficiare l’intera umanità. Questi principi sono necessari innanzitutto per delineare una governance dell’AI, e poi per regolare le attività di ricerca, sviluppo e implementazione dell’AI, con le relative ripercussioni sull’umanità.

Umanità sempre più al centro del dibattito: è stato notevole l’intervento di Moriba Jah, scienziato e ingegnere aerospaziale, che ha iniziato il suo discorso ringraziando gli antenati, la Madre Terra e il Padre Cielo, prima di lanciarsi in un discorso che univa tecnicismi e momenti di grande ispirazione. L’idea della Terra come nave spaziale è stata utilizzata per spiegare il progetto Wayfinder, che mira a prevedere in tempo reale l’orbita di migliaia di satelliti attorno alla Terra per prevedere e potenzialmente prevenire impatti catastrofici. Ma ciò che ha contraddistinto l’intervento di Jah è stato il continuo riferimento al ruolo dell’essere umano e alla necessità di empatia. Mi ha particolarmente colpito una sua affermazione: “Believing in Randomness is saying no to learning”.

3° insight: nel mondo dell’AI c’è sempre da imparare e non è mai troppo tardi per iniziare e studiare.

Vero genio dei nostri tempi, Jah, ha colto l’occasione per sottolineare l’importanza di un sistema di governance per l’AI, che dovrebbe comprendere almeno tre aspetti fondamentali:

- prevedibilità dei risultati;

- trasparenza del processo;

- responsabilità (accountability) delle decisioni.

A quel punto della conferenza, ho iniziato a percepire come l’agenda fosse stata progettata in modo davvero meticoloso, con un ritmo perfettamente scandito e interventi che si integravano alla perfezione l’uno con l’altro.

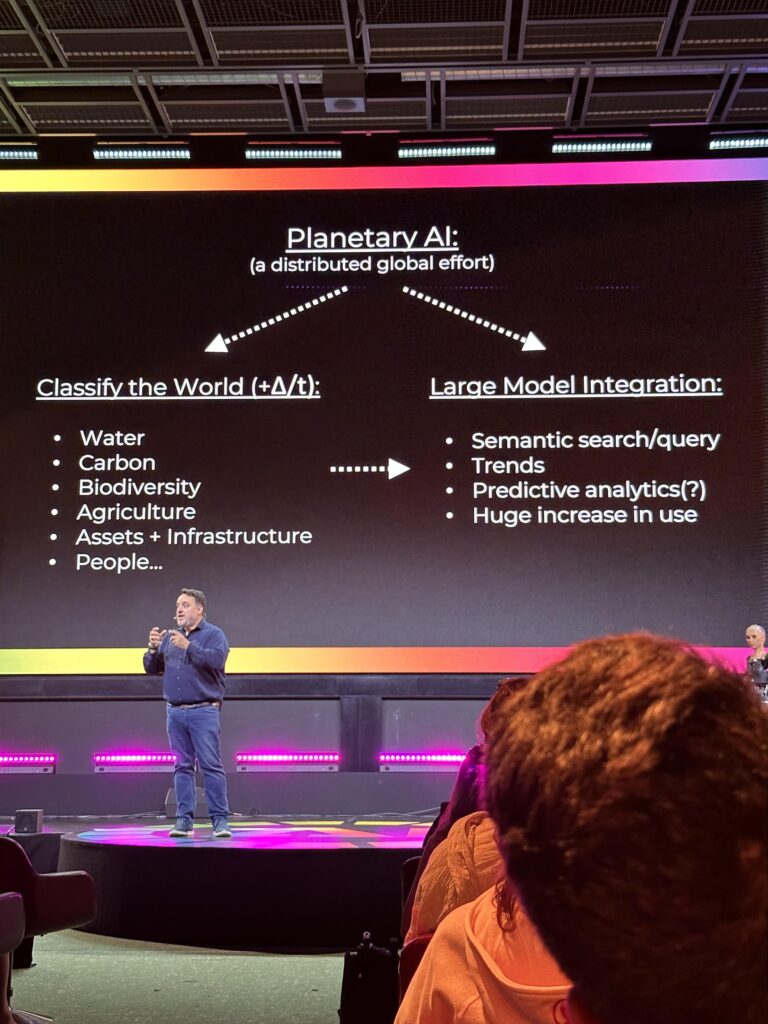

Infatti, subito dopo Jah, Andrew Zolli di Planet, azienda specializzata nell’osservazione satellitare della Terra, ha preso la parola.

Planet utilizza l’AI per gestire l’enorme quantità di dati che raccoglie praticamente su ogni metro quadrato del nostro pianeta. Zolli ha evidenziato un aspetto spesso trascurato: solo grazie all’AI siamo in grado di estrarre informazioni e approfondimenti da questa mole di dati che altrimenti nessun essere umano potrebbe utilizzare direttamente. Il ruolo dell’AI generativa, quindi, diventa quello di rendere queste informazioni accessibili al maggior numero possibile di persone, in modo semplice.

4° insight: l’enorme quantità di dati che abbiamo a disposizione può essere sfruttata ormai soltanto con l’AI (e in nessun altro modo).

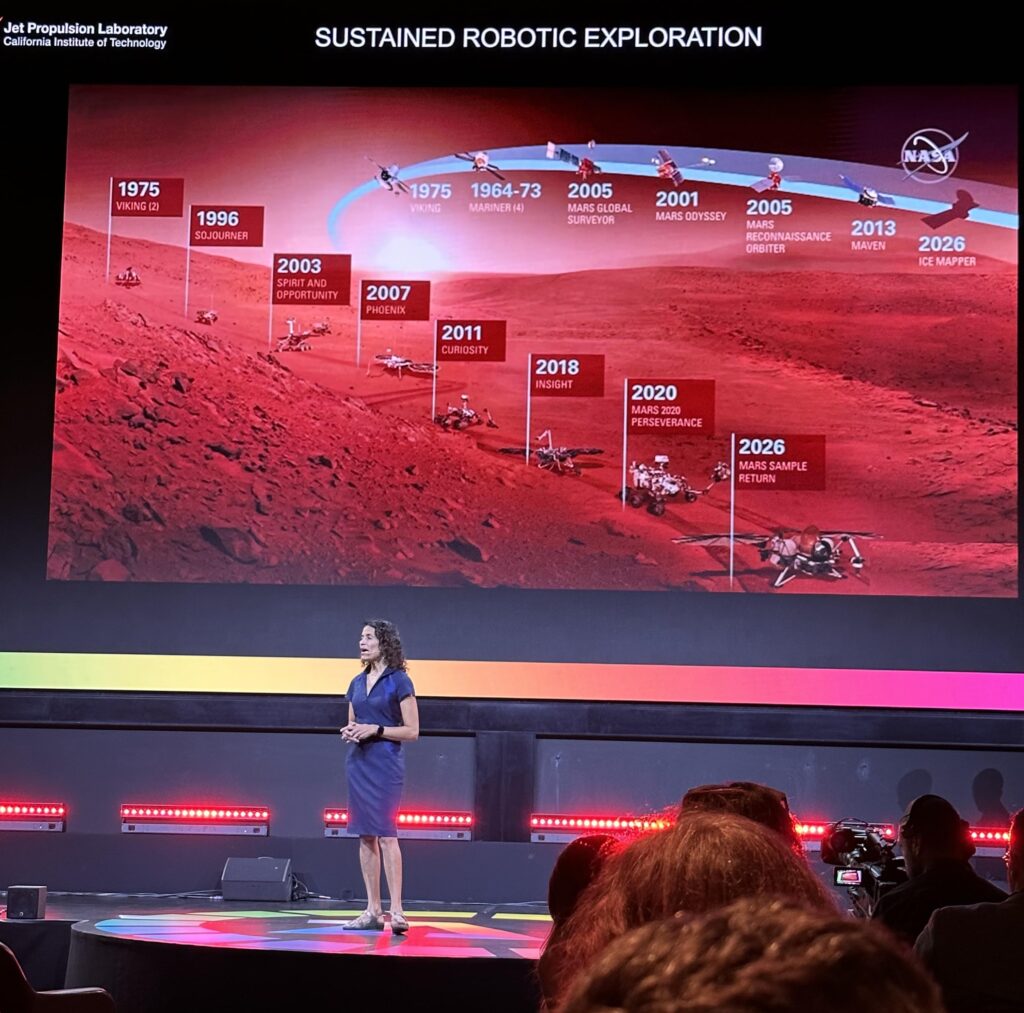

Dal Pianeta Terra a Marte con Vandi Verma, scienziata della NASA che ha descritto come l’AI sia fondamentale per l’esplorazione su Marte. La robotica avanzata e i sistemi di guida autonoma sono necessari per eseguire missioni che sarebbero impossibili da controllare a distanza dal nostro pianeta (ci vogliono oltre 24 minuti per trasmettere dati tra Terra e Marte).

5° insight: la tecnologia AI della guida autonoma ha senso sulla terra in alcuni (pochi) casi, ma è invece fondamentale per l’esplorazione spaziale.

Ma non solo droni e piccole sonde spaziali: all’evento AI for Good, i robot umanoidi hanno preso il palcoscenico insieme a David Hanson, il creatore di Sophia the Robot, il più famoso tra i robot “human-inspired”. Dopo una dimostrazione sul palco, l’impressione è che, grazie all’AI generativa, i robot possano finalmente offrire un’esperienza di conversazione realistica, cosa che era impossibile fino a pochi mesi fa.

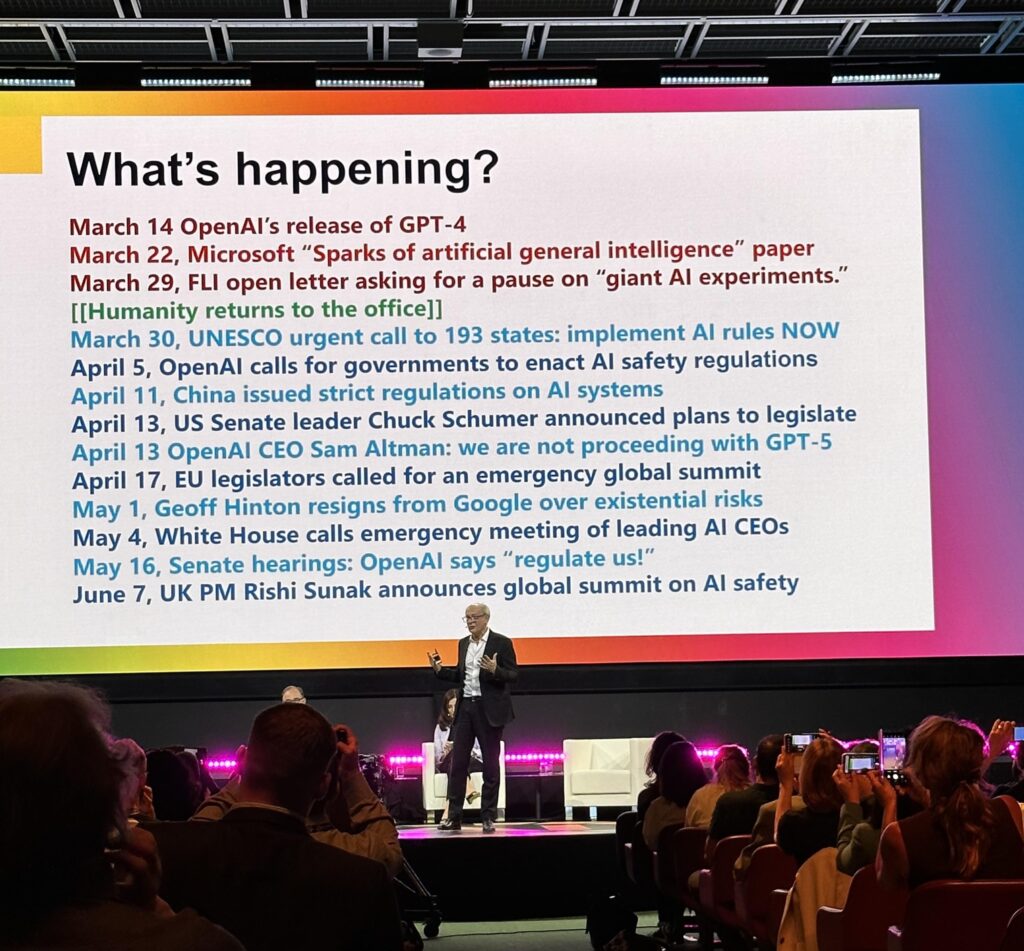

Il pomeriggio è iniziato con l’eccezionale intervento di Yuval Harari, intervistato da Nicholas Thompson (The Atlantic). Harari sostiene la necessità di un controllo rigoroso sull’AI, non tanto per quanto riguarda gli sviluppi, quanto piuttosto in termini di rilascio al pubblico di nuove funzionalità, cioè non tanto in riferimento al development, quanto al deployment. L’assunto è che l’AI, pur essendo in grado di portare benefici immensi all’umanità, sia potenzialmente pericolosa. Questo perché si tratta di una tecnologia qualitativamente diversa dalle altre: può prendere decisioni in modo autonomo e può generare idee “nuove”. Essa richiede quindi regolamentazioni, soprattutto considerando che gli esseri umani non hanno una buona storia di capacità di controllo delle grandi innovazioni tecnologiche (ovvio il riferimento alla bomba atomica). Harari vede un pericolo nell’eventuale messa in discussione dell’essenza stessa della società democratica: si tratta di uno scenario distopico più simile a quello descritto da Black Mirror che non quello di Terminator. Un’AI che non si presenta come tale potrebbe farci perdere il controllo delle conversazioni pubbliche, amplificando esponenzialmente i rischi che abbiamo intravisto nei social media. Ecco perché, secondo lui,

“È fondamentale capire se sto parlando con un essere umano o con un’AI”.

Harari sostiene che le grandi aziende che sviluppano modelli di AI dovrebbero dedicare il 20% del loro budget al miglioramento della sicurezza dei sistemi, seguendo l’esempio di altri settori regolamentati, come l’industria automobilistica o aeronautica.

6° insight: la minaccia dell’AI non riguarda la fine del mondo in stile Skynet ma la fine della democrazia moderna.

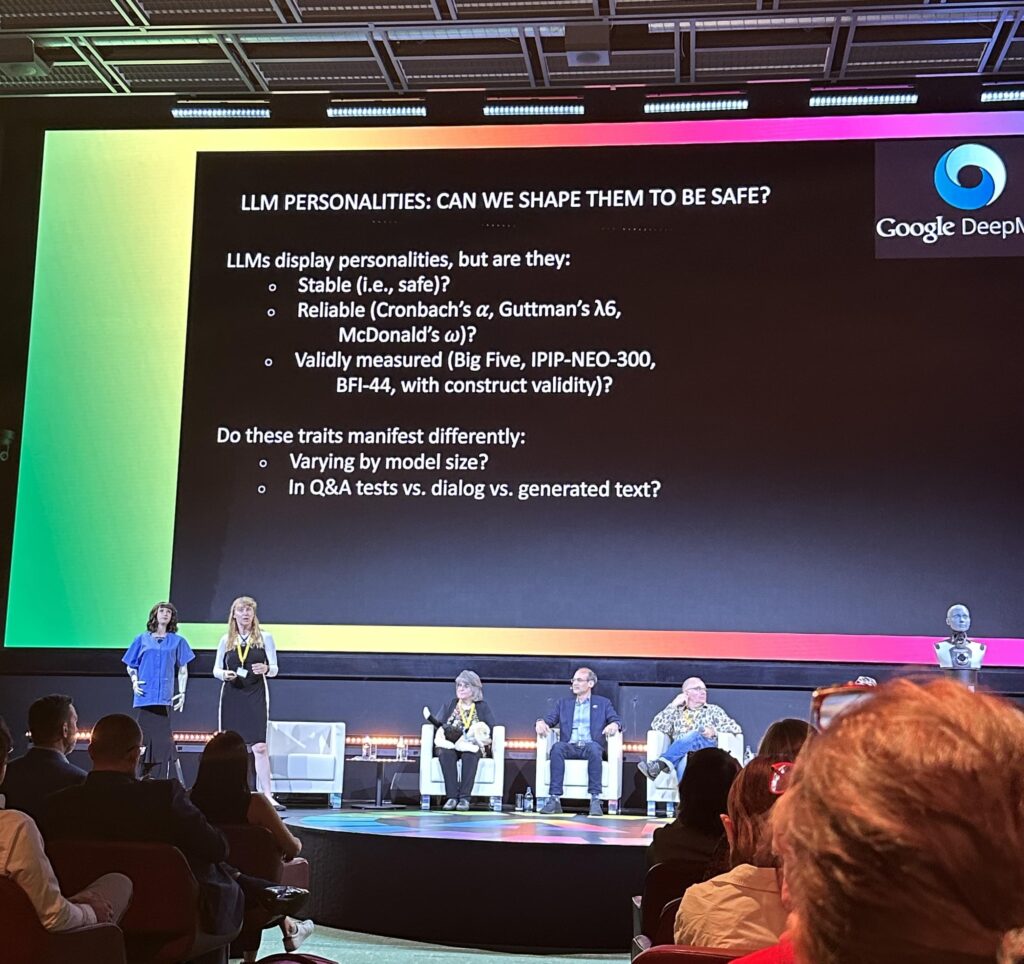

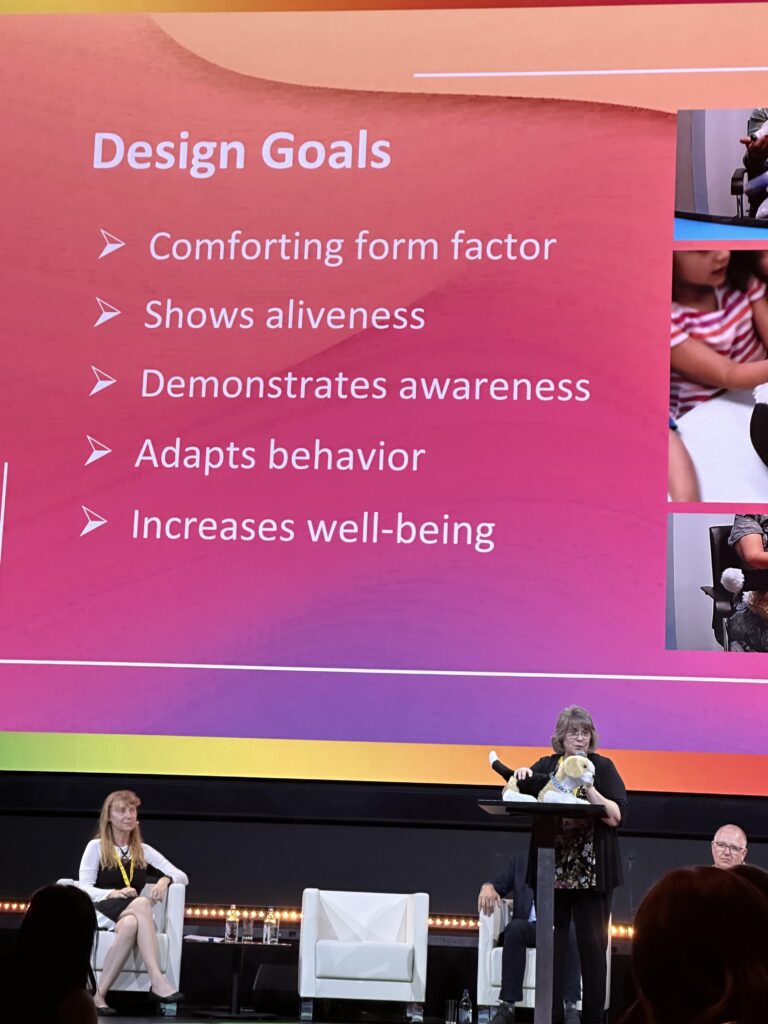

Quasi nessun riferimento ai rischi legati alla perdita di posti di lavoro, che invece è stato lo spunto di avvio del panel moderato dalla fantastica Maja Mataric: abbiamo di fronte solo due possibili scenari, automation o augmentation. Ovvero la sostituzione del lavoro umano o il miglioramento (enhancement) di tale lavoro. Diventa importante definire uno standard di interazione uomo-robot in cui l’AI possa abilitare le persone a comportarsi e agire meglio. Non dovrebbe inoltre sorprenderci che in un paper in fase di pubblicazione su arXiv, il team di ricerca capitanato dalla Mataric abbia misurato e validato la personalità e il comportamento di alcuni modelli linguistici (LLM) in base ad alcuni standard riconosciuti (come ad esempio il Big Five).

Il panel, incentrato sul concetto di interazione uomo-robot e in generale uomo-macchina ha visto anche altri protagonisti, che hanno sollevato i due temi secondo me più rilevanti. In primo luogo, esiste un urgente bisogno di una carta etica riconosciuta per l’industria della robotica, al fine di instaurare un’autoregolamentazione. Tuttavia, fino ad oggi, non esiste nulla del genere, il che solleva preoccupazioni riguardo alla sicurezza.

Inoltre, il concetto di robotizzazione supera di gran lunga l’idea di robot umanoidi. Il pensiero di un robot che svolge lavori domestici o di un veicolo autonomo guidato da un robot è fuorviante. In realtà, è molto più probabile che l’automazione futura sia “invisibile”, modificando i nostri dispositivi di uso quotidiano per renderli più autonomi e meno dipendenti dall’interazione umana.

Uno scenario potenziale potrebbe essere l’automobile che non necessita di un conducente, quindi non ha bisogno di un volante. Allo stesso modo, l’AI e la robotica stanno diventando sempre più rilevanti nel settore sanitario. Il futuro della salute è digitale, non solo per quanto riguarda le connessioni, ma anche l’accesso ai dati, e l’AI generativa svolge un ruolo centrale in questo processo.

7° insight: l’innovazione dell’automazione animata dall’AI non è soltanto quella dei robot, ma prevederà capacità intellettuali e fisiche sostanzialmente diverse dall’umanizzazione che avevamo in mente nei film di fantascienza.

Altre due industrie importanti che potrebbero influenzare l’evoluzione globale dell’AI sono l’aviazione civile e l’energia nucleare. Questi settori hanno una governance definita a livello internazionale e potrebbero quindi ispirare il prossimo Global Compact 2024 sull’AI, come annunciato durante la conferenza. Secondo Amandeep Singh Gill, rappresentante ONU per la Tecnologia, l’obiettivo principale è promuovere gli effetti benefici e minimizzare i rischi di questa tecnologia digitale. Questo sarà raggiunto attraverso meccanismi di sicurezza, regole di governance e standard condivisi.

Un esempio di questo tipo di cooperazione internazionale è l’accordo tra gli USA e l’UE sulla modellazione degli eventi atmosferici estremi. Ne hanno discusso Anne Neuberger, rappresentante della Casa Bianca, e Roberto Viola, direttore generale DG Connect della Commissione Europea. Hanno sottolineato l’importanza di un’IA “trustworthy” (affidabile) e “human-centric” (centrata sull’essere umano), un approccio all’intelligenza artificiale che sia inclusivo, sicuro e responsabile. Questi concetti sono stati poi ripresi da altri relatori nel secondo giorno della conferenza.

8° insight: l’AI deve portare ad una nuova stagione di cooperazione internazionale, ma dove sono Russia, Cina e India?

La giornata si è conclusa con un intervento di Lori Rodney di Shutterstock, partner della conferenza e protagonista nel campo dell’AI generativa con la recente iniziativa shutterstock.ai.

AI for Good 2023 – Secondo giorno

Il secondo giorno della conferenza è iniziato con una performance musicale a cura del batterista Jojo Mayer, che collabora con intelligenze artificiali per migliorare le sue capacità artistiche.

A differenza del primo giorno, il contenuto della seconda giornata è stato più focalizzato sulla tecnologia e meno sulle questioni istituzionali, con presentazioni degne dei migliori TED Talks.

La serie di presentazioni eccezionali della seconda giornata è stata inaugurata da Bernard Maissen del governo svizzero. Ha sottolineato l’importanza di regolamentare non l’IA in sé, ma il suo utilizzo, per assicurare che l’innovazione rimanga sempre possibile per il progresso dell’umanità. Ha sottolineato il ruolo guida degli Obiettivi di Sviluppo Sostenibile (SDG) nel dirigere la nostra attenzione verso gli obiettivi più importanti da perseguire per il bene dell’umanità.

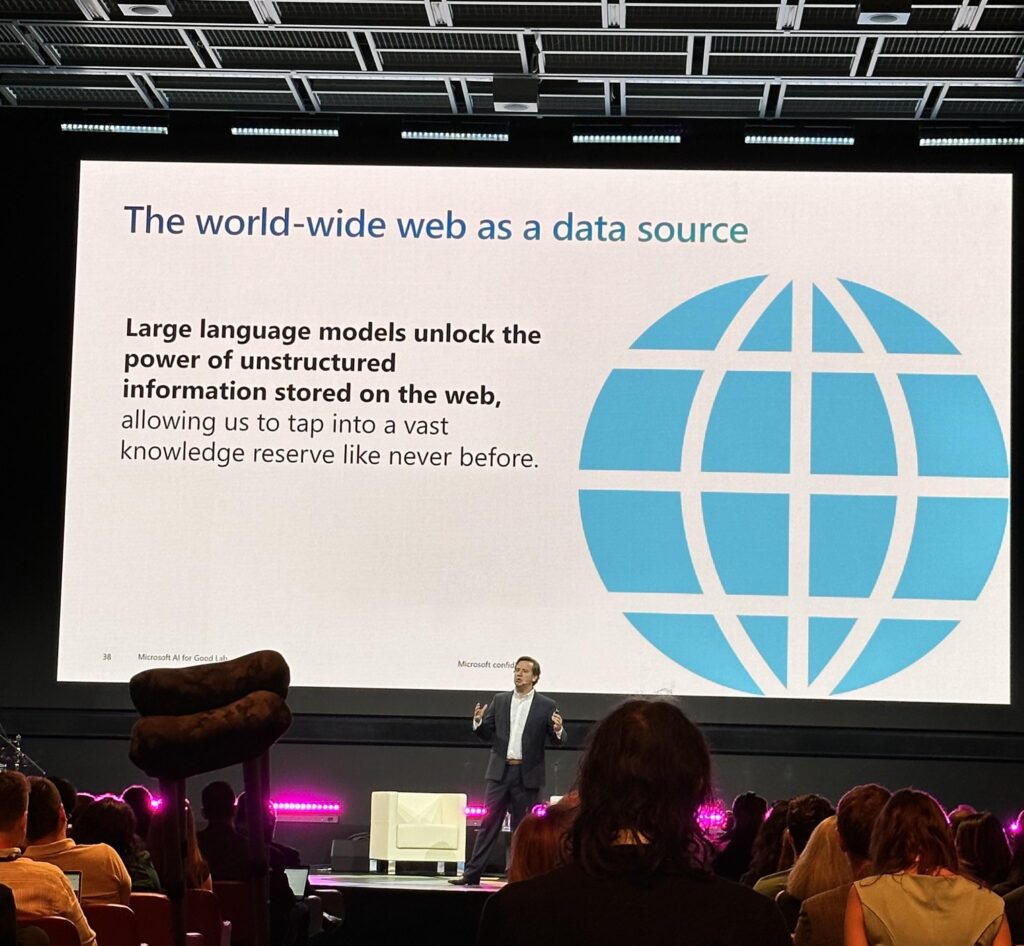

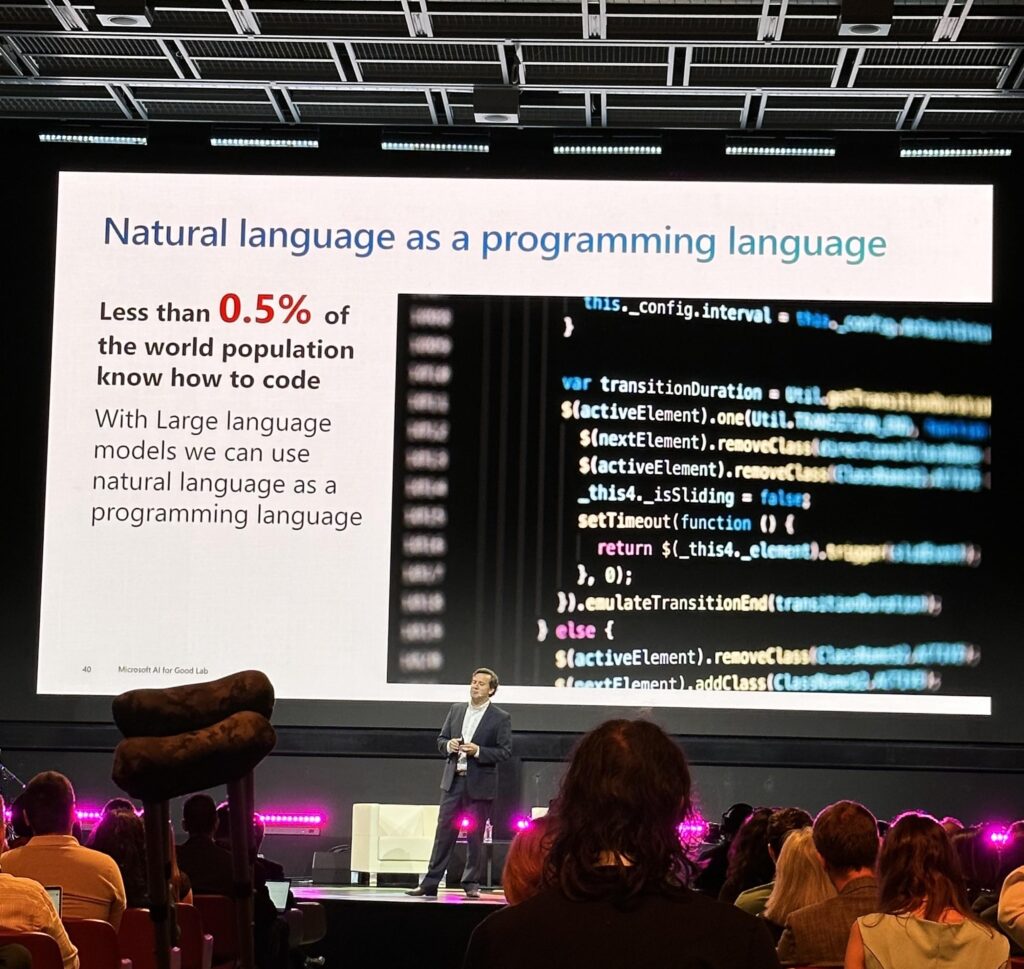

Juan Lavista Ferres del gruppo AI for Good Lab di Microsoft ha acceso l’entusiasmo dei partecipanti con una domanda provocatoria:

“La nostra generazione sarà veramente ricordata per aver usato l’IA soltanto per far cliccare le persone sugli annunci pubblicitari?”

La sua risposta è che l’AI potrebbe essere l’unico strumento capace di risolvere alcuni dei problemi più pressanti dell’umanità. E in fondo, siamo una specie che ama le sfide: dopo tutto, abbiamo mandato un uomo sulla Luna prima di inventare le valigie con le rotelle.

Nello stesso modo in cui l’elettricità ha rivoluzionato il benessere della specie umana nel 19° secolo, l’IA è destinata a svolgere un ruolo significativo nel promuovere una maggiore diffusione dei diritti umani nel futuro. Non è detto che la sicurezza debba essere l’unico obiettivo: ad esempio, la soluzione elettrica basata sulla sicurezza (DC) proposta da Edison si è dimostrata meno efficace rispetto alla soluzione basata sulla distribuzione su larga scala (AC) di Tesla. Il punto fondamentale è comprendere che l’IA è sia uno strumento di potenziale utilità che un’arma: i modelli linguistici di apprendimento automatico (LLM) sono gli strumenti che possono aiutarci a trarre vantaggio dai dati non strutturati che popolano la nostra infosfera.

9° insight: occorre regolamentare l’uso dell’AI in modo da aumentarne i benefici su larga scala, la sicurezza non deve essere l’unico metro di giudizio.

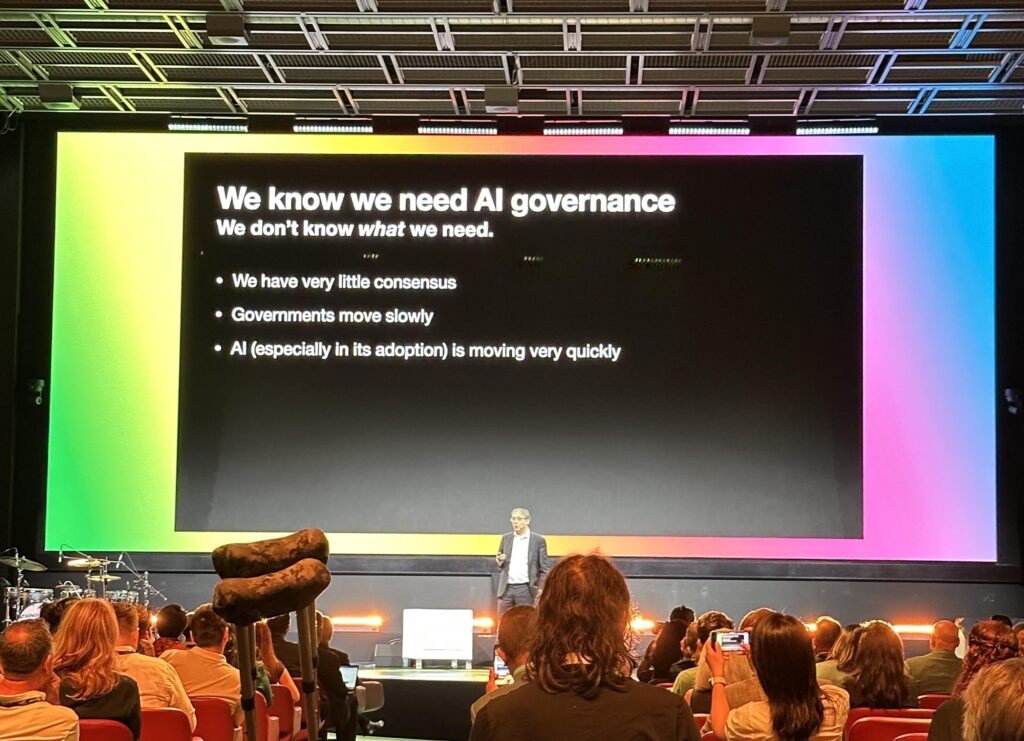

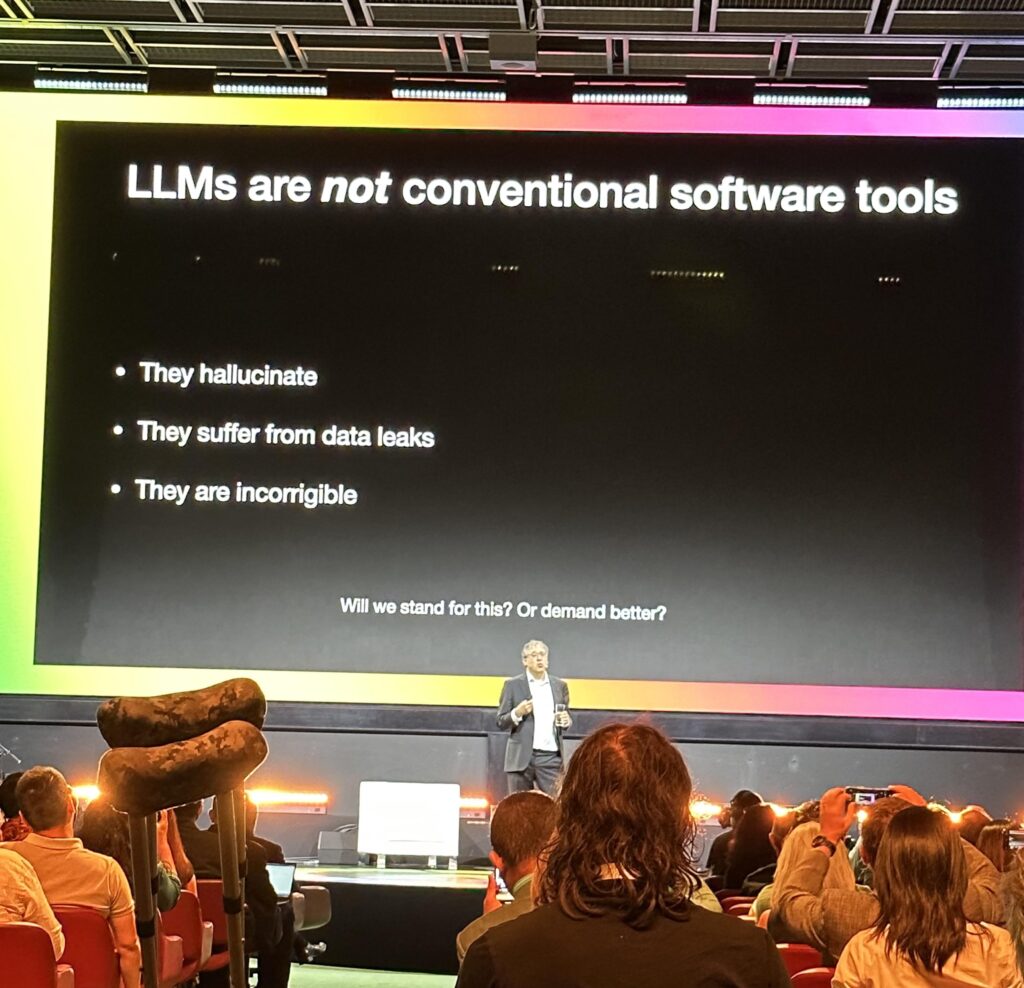

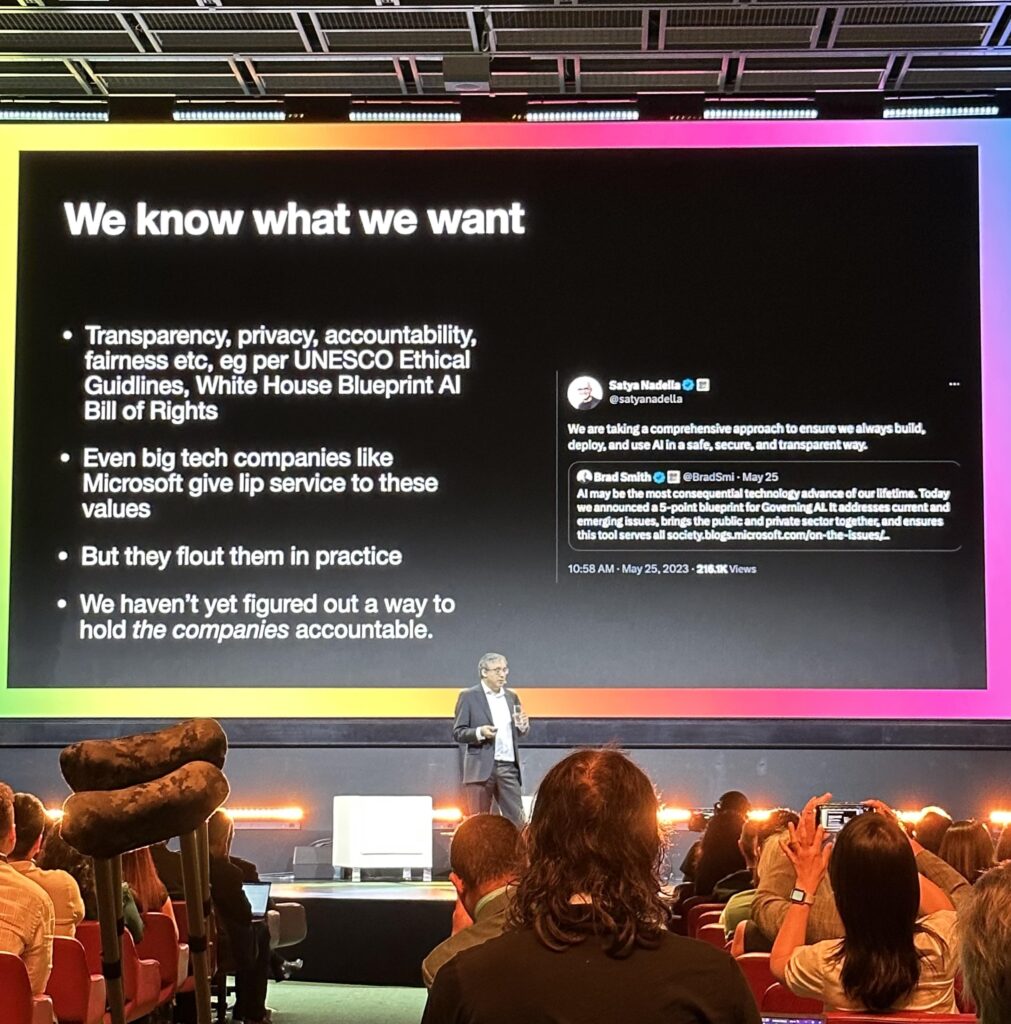

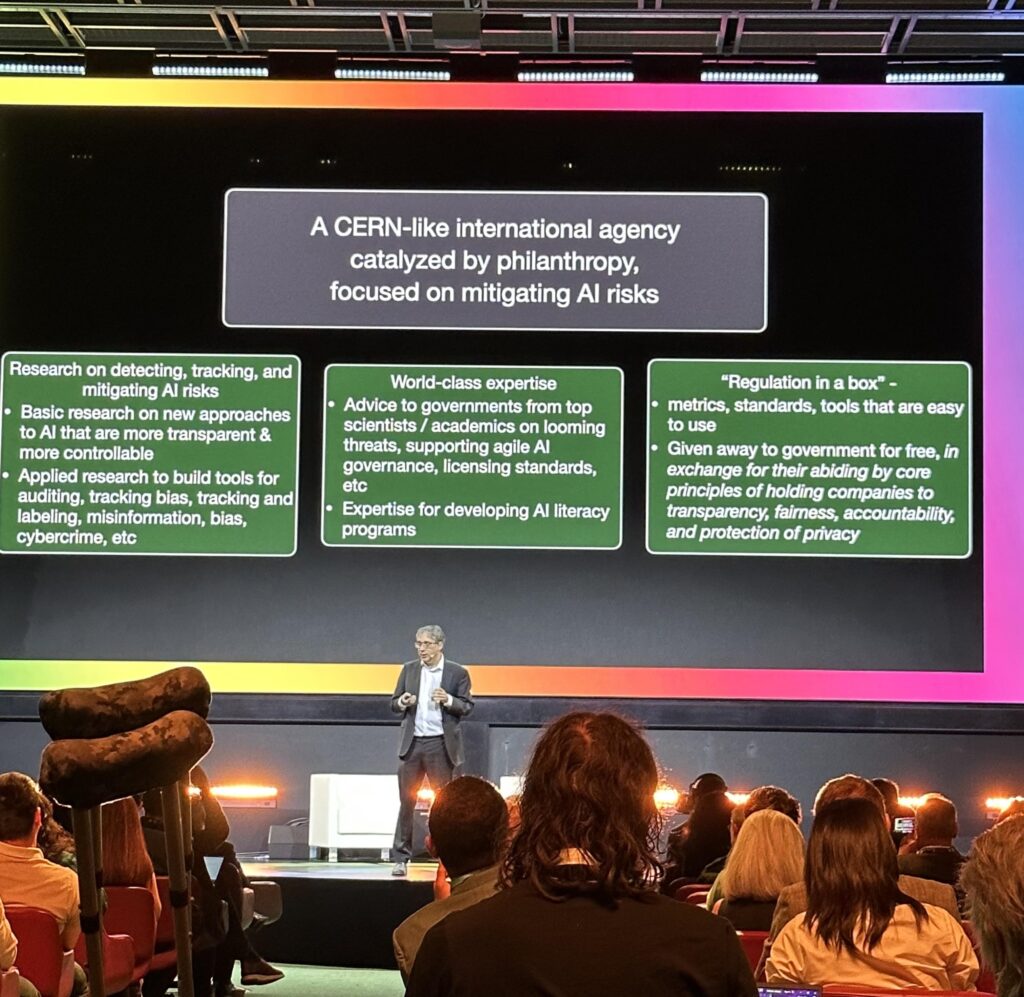

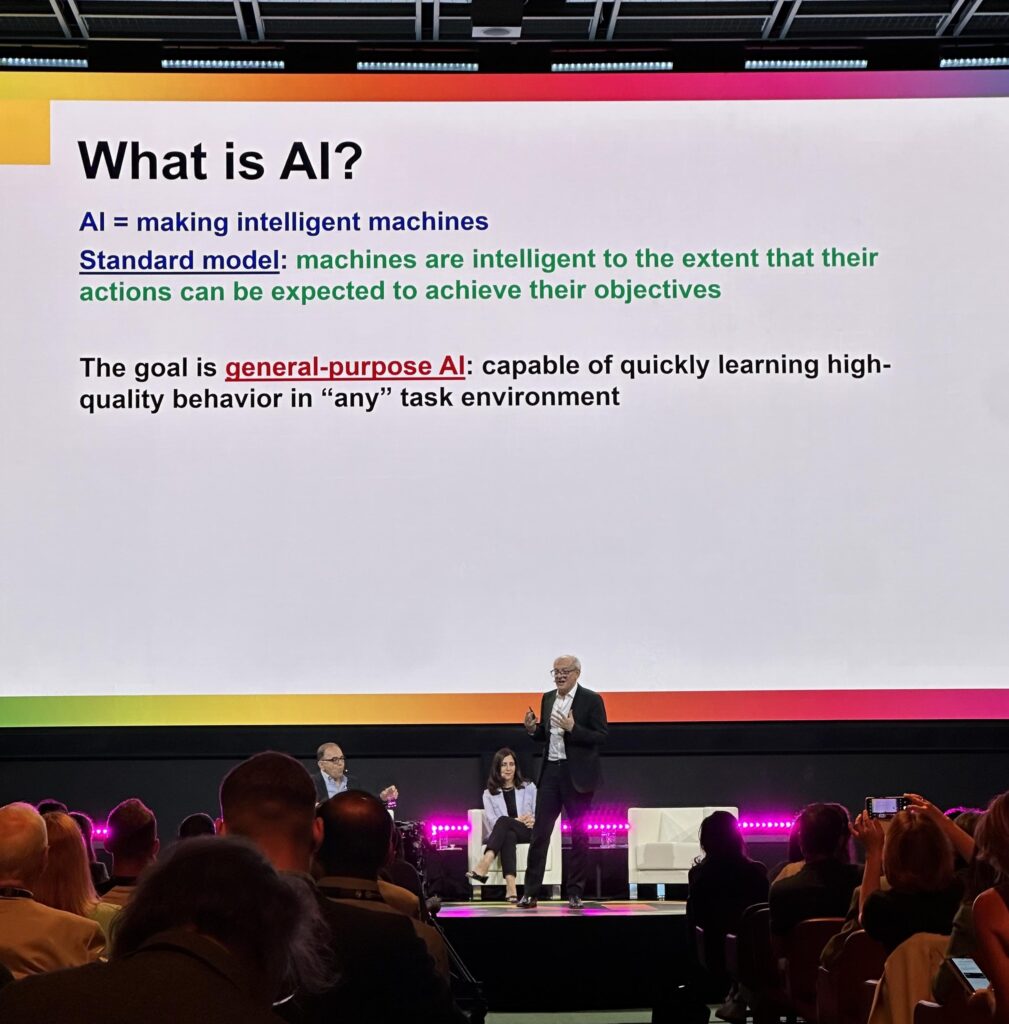

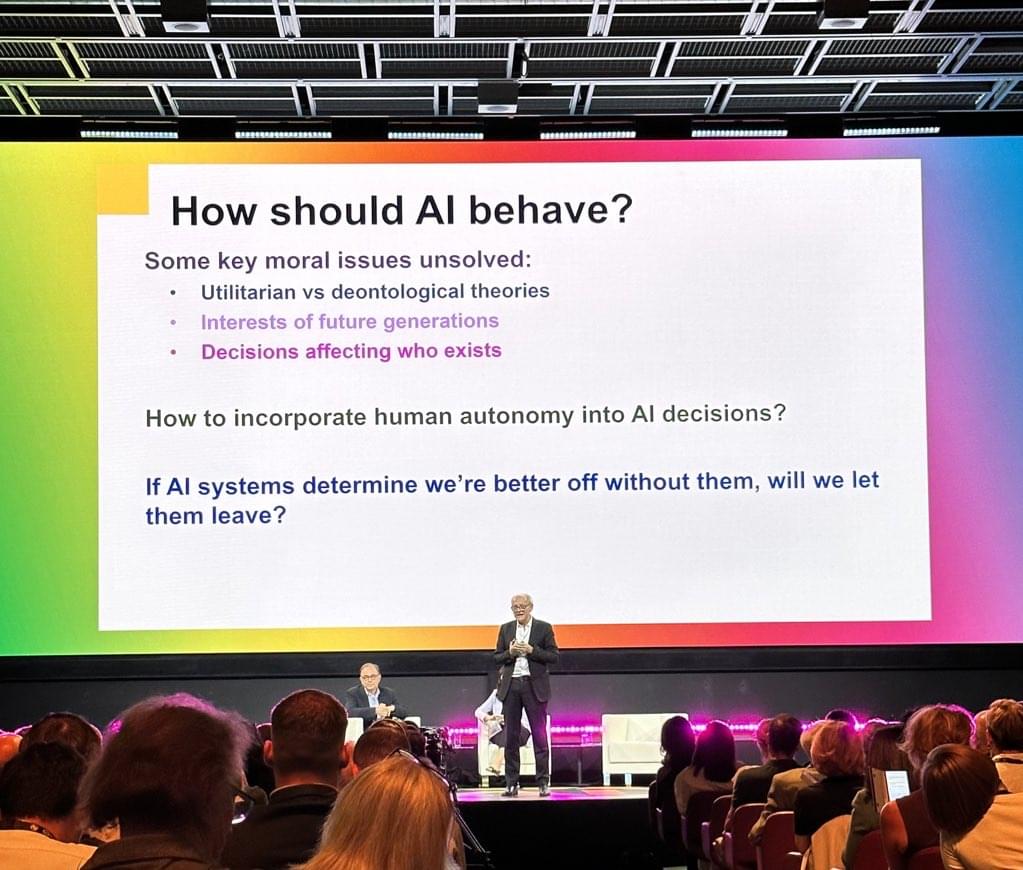

Il Professore Gary Marcus della New York University ha identificato le tre grandi sfide che l’umanità deve affrontare per assicurare un futuro positivo: la governance, l’allineamento e i valori. La governance si riferisce alla regolamentazione dell’AI; l’allineamento riguarda la capacità di allineare l’AI con gli obiettivi umani di sopravvivenza e prosperità (e prevenire che l’AI anteponga i suoi interessi una volta che supererà l’intelligenza umana); i valori rappresentano la necessità di basare ogni decisione su valori condivisi a livello globale, piuttosto che sulle scelte individuali.

Dal punto di vista tecnologico, ci troviamo ancora all’inizio del percorso dell’IA, come affermato da Marcus. Questo è dimostrato dalle cosiddette “allucinazioni” dei modelli di apprendimento automatico, che rappresentano un livello di qualità inaccettabile dal punto di vista del software e sono, in effetti, dei veri e propri malfunzionamenti.

10° insight: gli attuali modelli linguistici alla base della AI sono ancora ad un livello primordiale, pieno di malfunzionamenti tecnici.

Una prospettiva affascinante è stata offerta da Orly Lobel, esperta di sistemi cognitivi e autrice del libro “The Equality Machine”. Secondo Lobel, esistono numerosi pregiudizi e bias nel campo dell’IA, tra i quali:

- Il doppio standard: il livello di sicurezza richiesto per l’IA dovrebbe essere lo stesso che ci aspettiamo dagli esseri umani. Ad esempio, la guida autonoma non potrà mai raggiungere una sicurezza del 100%.

- Ignorare la scarsità delle risorse: l’IA e la digitalizzazione potrebbero essere strumenti per colmare le lacune nell’accesso alle risorse, come l’istruzione e la sanità.

- Il dualismo libertà-proibizionismo: la regolamentazione dell’IA richiede sfumature di giudizio, come di solito accade per i sistemi complessi.

- La (falsa) importante dello human-in-the-loop: non sempre è ottimale affidare una decisione a un essere umano. Ad esempio, ci sono procedure nel settore dell’aviazione che richiedono un’automazione completa per garantire la sicurezza.

Il concetto di ‘automation rights’, o diritti di automazione, è emerso fortemente: il diritto di automatizzare certi processi della nostra vita o del nostro lavoro necessita di un approccio sofisticato verso la fiducia nell’IA, che eviti eccessi sia in termini di diffidenza (undertrust) che di fiducia cieca (overtrust).

11° insight: gli esseri umani devono poter essere liberi di automatizzare ciò che è giusto automatizzare, per il bene comune.

Il problema dei bias è stato toccato in modo significativo anche durante il secondo intervento di Shutterstock alla conferenza. Alessandra Sala e Sejal Amin hanno sollevato la questione dell'”Uncontrolled Crawling”, ossia la raccolta incontrollata di dati, nelle piattaforme di arte generativa come Midjourney. Questo fenomeno può generare bias, discriminazioni, violazioni del copyright, ma anche un’esclusione totale degli artisti dai benefici economici derivanti dal contenuto su cui le macchine si allenano.

Pertanto, diventa fondamentale posizionare l’artista (umano) al centro del processo per garantire che l’arte prodotta dalla collaborazione tra uomo e IA possa beneficiare i creatori di contenuti.

Artisti come l’olandese Jeroen van der Most evocato da Shutterstock e i cinque protagonisti del panel “Creative Visionaries”: Rania Kim, Christian Mio Loclair, Sougwen Chung e Harry Yeff, stanno esplorando il ruolo dell’arte nel farci sondare la nostra umanità attraverso l’interazione con l’IA.

Questo processo serve sia a far evolvere la nostra umanità che a spingere le macchine al limite delle loro potenzialità tecniche. In questo modello ibrido uomo+AI, il ritmo accelerato dell’innovazione rappresenta la sfida più grande, una sfida per la quale la nostra cultura attuale non è del tutto preparata. Da questo panel è emerso un concetto molto affascinante:

“Machines need better Humans”

Le macchine necessitano di essere umani migliori, nel senso che ci sollecitano a scoprire ciò che veramente costituisce l’essenza della nostra umanità, in termini di connessioni sociali e capacità espressive. Ed è verso questa direzione che dobbiamo muoverci.

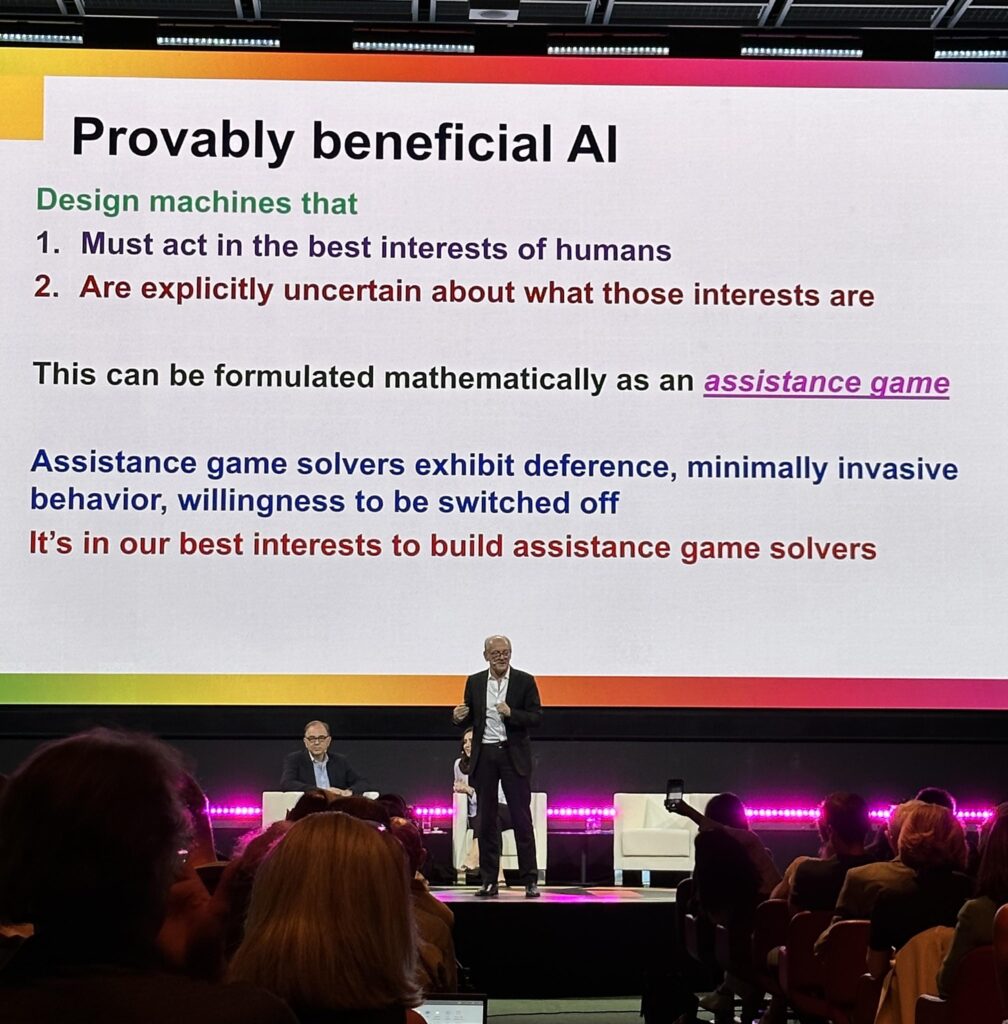

Successivamente, ha preso la parola un altro docente, Stuart Russell della University of California, Berkeley. Ha presentato la situazione in termini estremamente chiari: i modelli di Linguaggio di Grandi Dimensioni (LLM) raggiungeranno presto un punto di saturazione tecnica, in quanto non ci sarà più testo originale da acquisire nell’intero universo. Pertanto, l’evoluzione dovrà concentrarsi sulla capacità degli algoritmi di comprendere meglio il proprio comportamento e gli scopi per i quali vengono utilizzati. Sarà necessario affrontare alcune questioni morali ancora aperte riguardanti il valore dell’autonomia umana rispetto alle macchine.

Joanna Shields, ex Ministro nel governo britannico e attuale CEO di BenevolentAI, ha sottolineato come sia necessario che la tecnologia dell’Intelligenza Artificiale venga regolamentata, per evitare che diventi un privilegio esclusivo dei ‘potenti’, ovvero coloro che dispongono di risorse intellettuali ed economiche sufficienti per trarne vantaggi significativi. Si tratta di un fenomeno già osservabile con i Social Media, che hanno creato profonde disparità.

A concludere la seconda giornata di conferenze è intervenuto il visionario Ray Kurzweil, imprenditore, pensatore e futurologo noto per aver previsto la ‘singolarità’ – il momento in cui l’intelligenza artificiale supererà l’intelligenza umana – per il 2029. Kurzweil ha espresso la convinzione che, nonostante attualmente gli esseri umani abbiano ancora un vantaggio rispetto alle macchine nella capacità di creare e apprezzare la musica, e di provare emozioni, non passerà molto tempo prima che anche questo divario venga colmato. E in quel momento, avremo raggiunto la ‘singolarità’. Gli esseri umani dovranno abituarsi a convivere con queste intelligenze basate sul silicio e ad avere delle vere e proprie ‘espansioni’ del proprio cervello. Dopo tutto, non siamo già ‘aumentati’ dalle capacità del nostro smartphone? Pensate, ad esempio, a quanto siate dipendenti dal vostro telefono quando vi trovate in un luogo sconosciuto in vacanza, forse all’estero, e lo utilizzate per comprendere la lingua locale o per trovare un ristorante in cui pranzare.

12° insight: il presente e il futuro è dell’umanità aumentata, sta a noi assicurarci che non ne venga fatto un uso sbagliato.

La sensazione è che le “macchine stanno arrivando”, ma la storia umana ci ha dimostrato che l’impatto delle nuove tecnologie può essere positivo. Quindi, non ci resta che preparare il terreno per far sì che l’Intelligenza Artificiale possa diventare una forza per il bene.

Cosa mi porto a casa dalla partecipazione ad AI for Good?

Ci troviamo di fronte a un momento storico: abbiamo la possibilità di utilizzare la tecnologia più rivoluzionaria della storia umana per affrontare i problemi più urgenti che l’umanità deve risolvere. I futuri scenari in cui l’AI non viene sfruttata o non viene applicata ai veri problemi dell’umanità non sono incoraggianti. Sembra proprio che non abbiamo scelta.

Io, personalmente, farò tutto il possibile per dare il mio contributo, con il supporto del fantastico team di Arkage. Presto condividerò delle novità (spero) interessanti.

🎁 Bonus Content: le migliori slide delle presentazioni dell’AI for Good

Ricordate, l’intelligenza artificiale è qui per rimanere. La sua potenziale influenza sul nostro mondo è enorme, e abbiamo tutti un ruolo da giocare nel plasmare il futuro. Che sia per il bene di tutti.