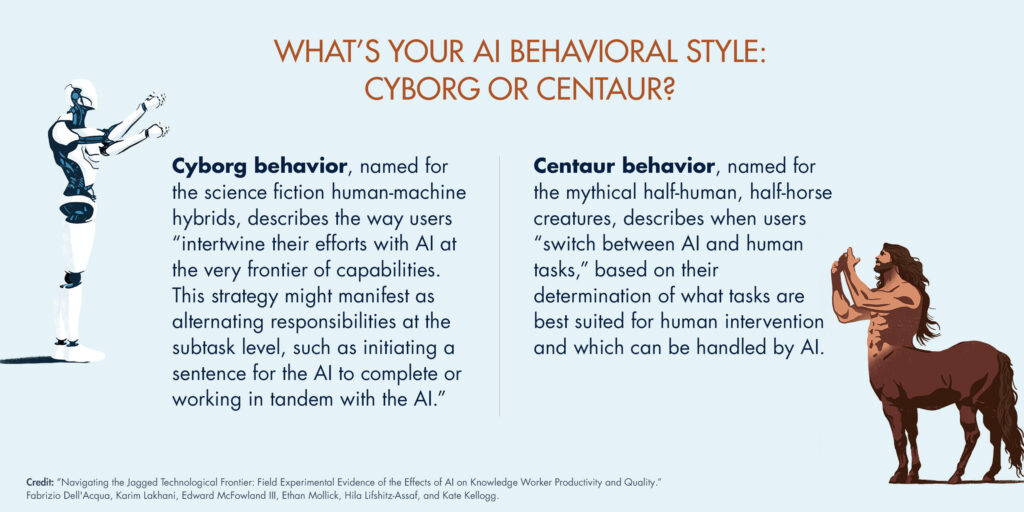

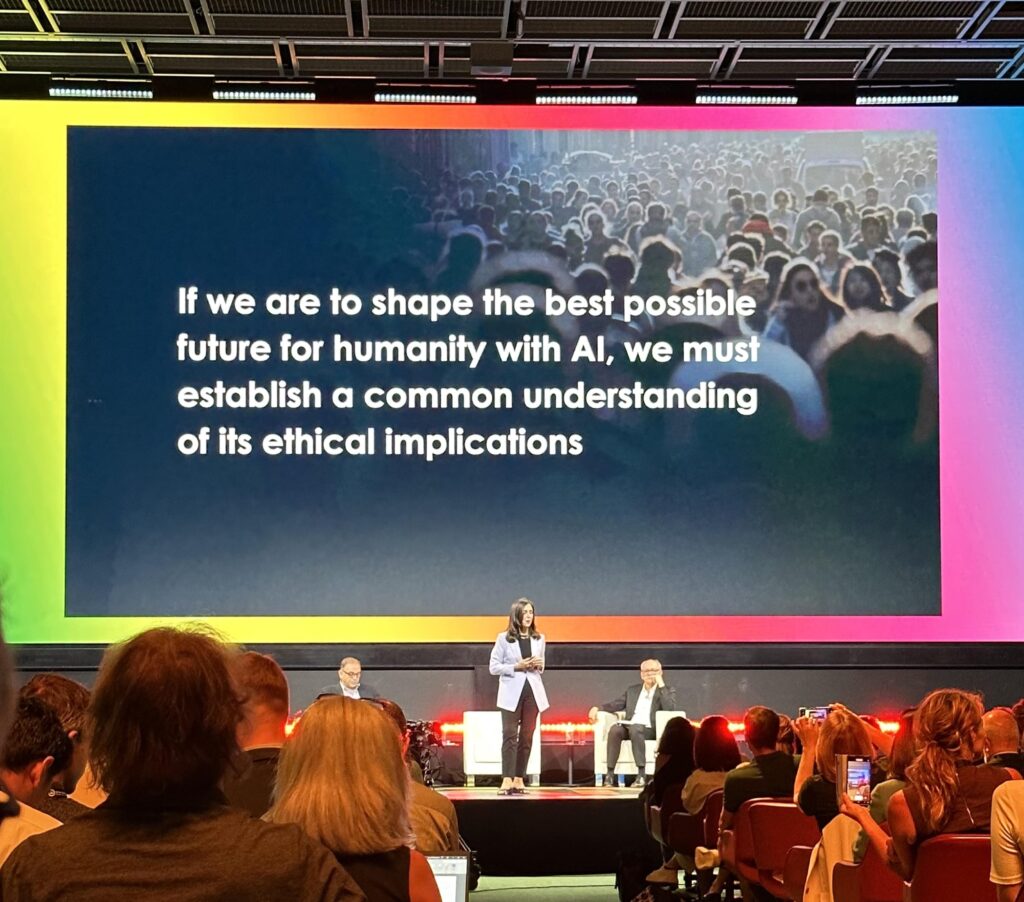

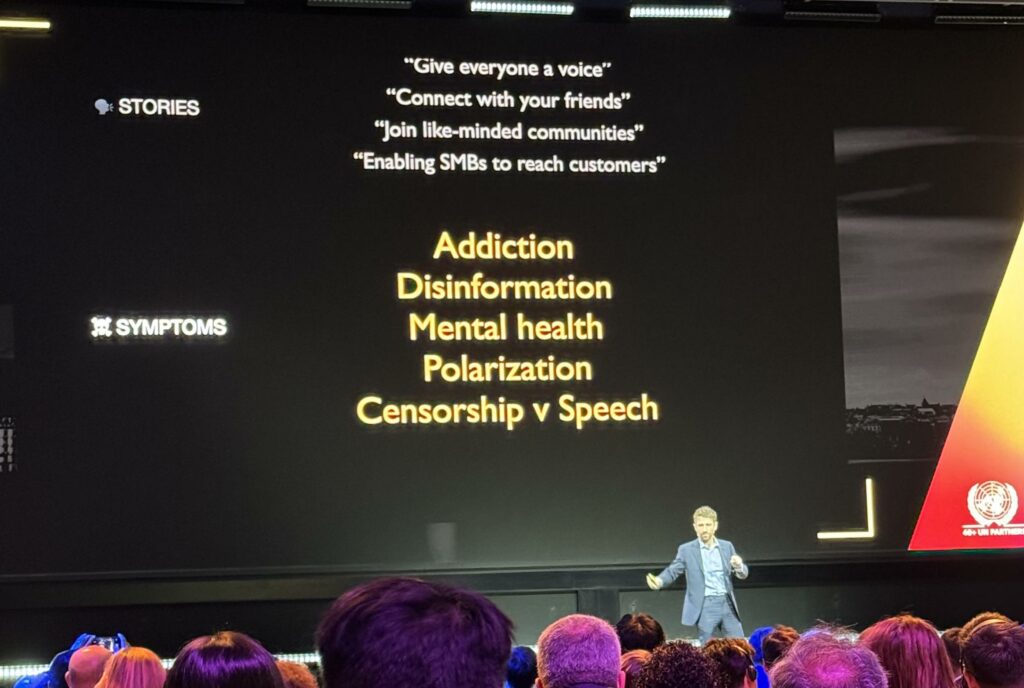

Il 30 maggio 2024, la Segretaria Generale dell’ITU, Doreen Bogdan-Martin, ha dato il via alla conferenza AI for Good 2024 a Ginevra con un discorso ricco di passione e determinazione. Il fulcro del suo intervento era l’urgenza di una collaborazione globale per assicurare che l’intelligenza artificiale (AI) sia sviluppata in modo sicuro, inclusivo e accessibile a tutti.

Bogdan-Martin ha sottolineato come l’AI abbia il potenziale per influenzare profondamente il futuro dell’umanità. Tuttavia, per realizzare questo potenziale, è cruciale che si operi all’interno di un quadro di standard internazionali ben definiti. Questi standard non solo faciliterebbero l’adozione dell’AI, ma garantirebbero anche una distribuzione equa dei benefici derivanti da queste tecnologie.

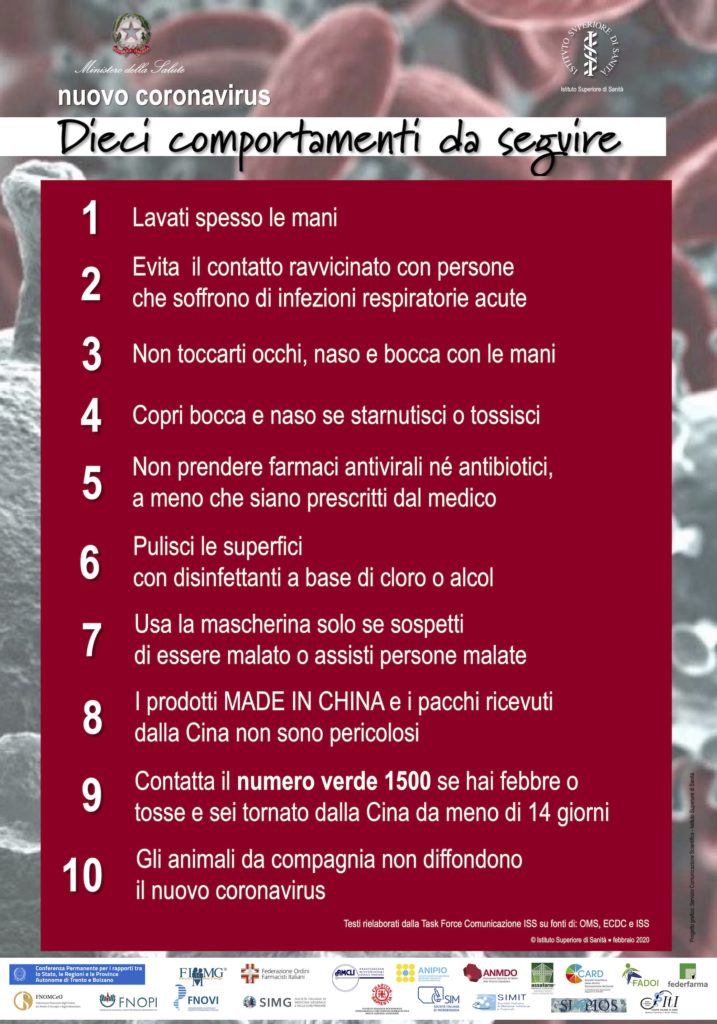

Con una domanda provocatoria,

“Quale sarà il ruolo dell’AI per il futuro dell’umanità?”

Bogdan-Martin ha invitato i partecipanti a riflettere su come l’AI possa essere utilizzata non solo per avanzare tecnologicamente, ma anche per migliorare la qualità della vita a livello globale.

Il discorso di apertura di Doreen Bogdan-Martin ha così dato il via alla conferenza AI for Good 2024, preparando il terreno per due giorni di discussioni intense e riflessioni sul ruolo trasformativo dell’AI nella società moderna.

Il Ruolo degli LLM nel Futuro delle Aziende

Il secondo intervento della conferenza AI for Good 2024 ha visto la partecipazione di Azeem Azhar, fondatore di Exponential View, che ha condiviso una visione affascinante e pragmatica sull’adozione degli LLM (modelli di linguaggio di grandi dimensioni) nel contesto aziendale.

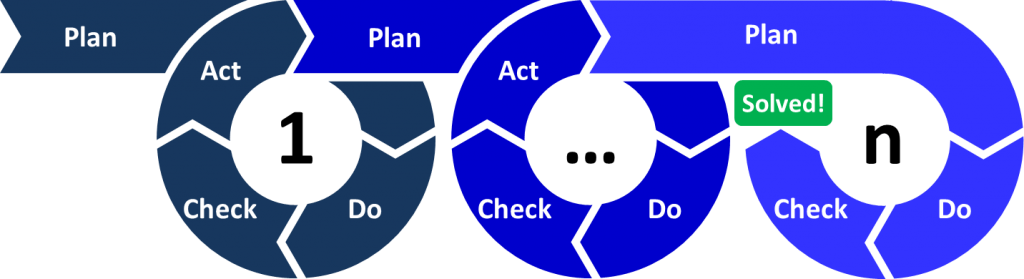

Azhar ha iniziato il suo discorso evidenziando che gli LLM sono la tecnologia con la più rapida adozione nella storia dell’umanità. Questo dato, secondo lui, non è solo una curiosità statistica, ma un segnale forte della natura esponenziale di questa tecnologia. Gli LLM non sono semplicemente una moda passeggera, ma rappresentano la spina dorsale delle aziende del futuro.

Un aspetto cruciale del discorso di Azhar è stata l’importanza della formazione del personale. Ha sottolineato che le aziende devono investire nella formazione dei propri dipendenti per sfruttare appieno le potenzialità degli LLM. Questo non solo aumenterà la produttività, ma permetterà anche di creare un ambiente lavorativo più innovativo e dinamico.

Azhar ha lanciato un appello diretto ai leader aziendali, esortandoli a non limitarsi ad osservare passivamente l’evoluzione degli LLM. In questa fase iniziale della tecnologia, è fondamentale che i leader aziendali adottino un approccio pratico e hands-on, sperimentando direttamente le applicazioni degli LLM per comprendere meglio come integrarli nelle loro strategie aziendali.

L’Impatto dei Social Media e dell’AI Generativa: Un’Analisi di Tristan Harris

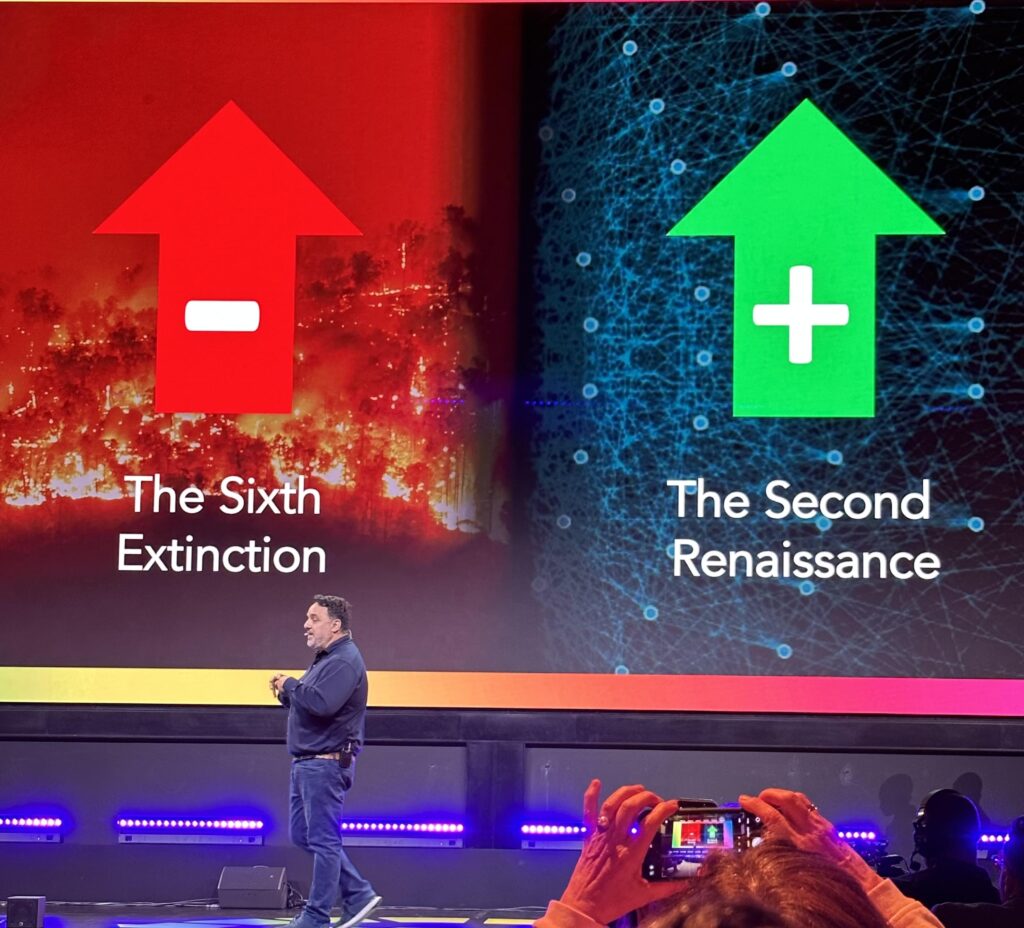

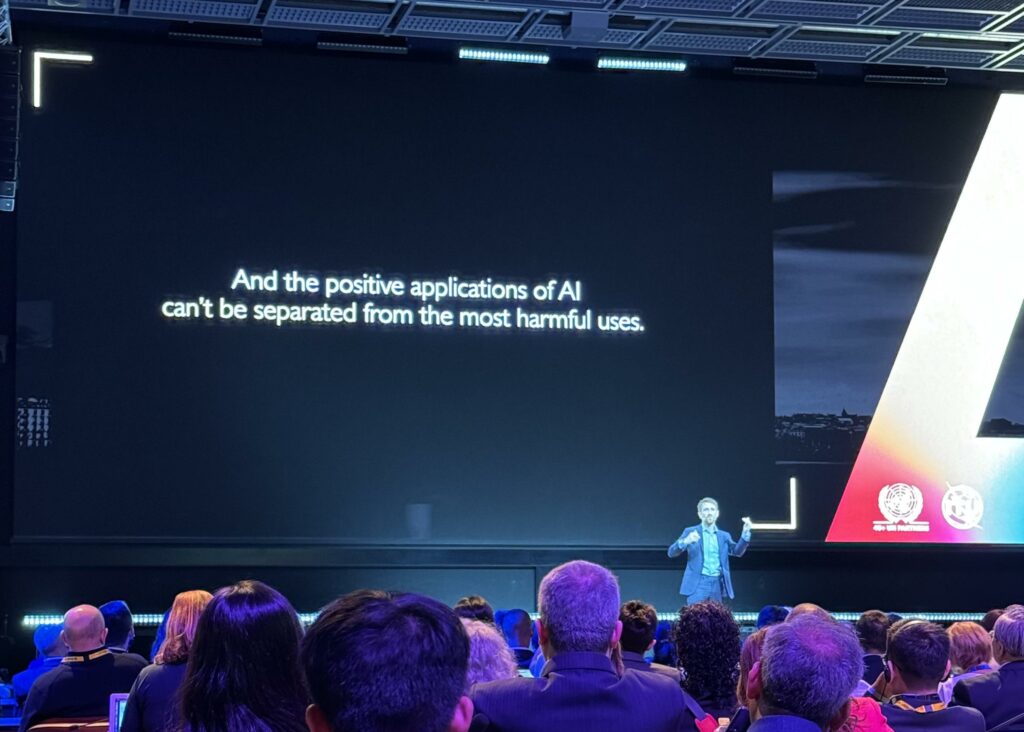

Tristan Harris, co-fondatore del Center for Humane Technology e noto per il suo documentario di successo “The Social Dilemma” su Netflix, ha offerto un’analisi critica e approfondita del nostro primo e secondo contatto con l’intelligenza artificiale (AI) durante la conferenza AI for Good 2024.

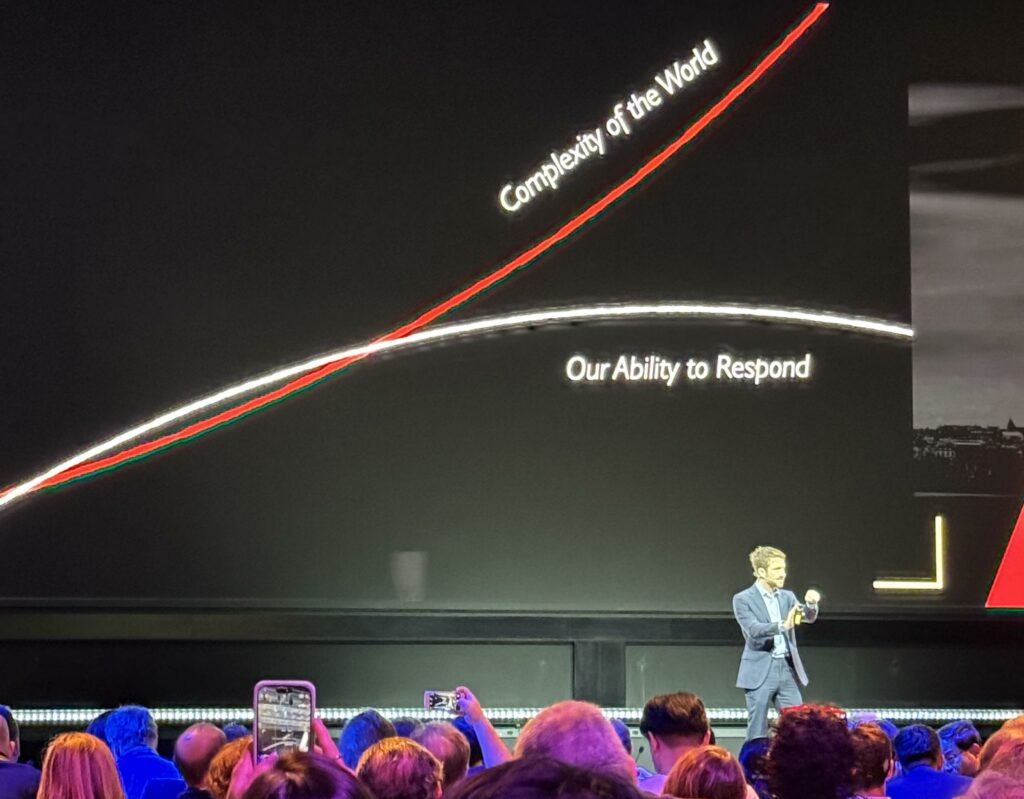

Harris ha iniziato il suo intervento riflettendo sull’influenza dei social media, il nostro primo vero contatto con l’AI. Ha sottolineato come questa interazione iniziale abbia portato a conseguenze negative significative: dipendenza, disinformazione, problemi di salute mentale, polarizzazione e il dilemma tra censura e libertà di parola.

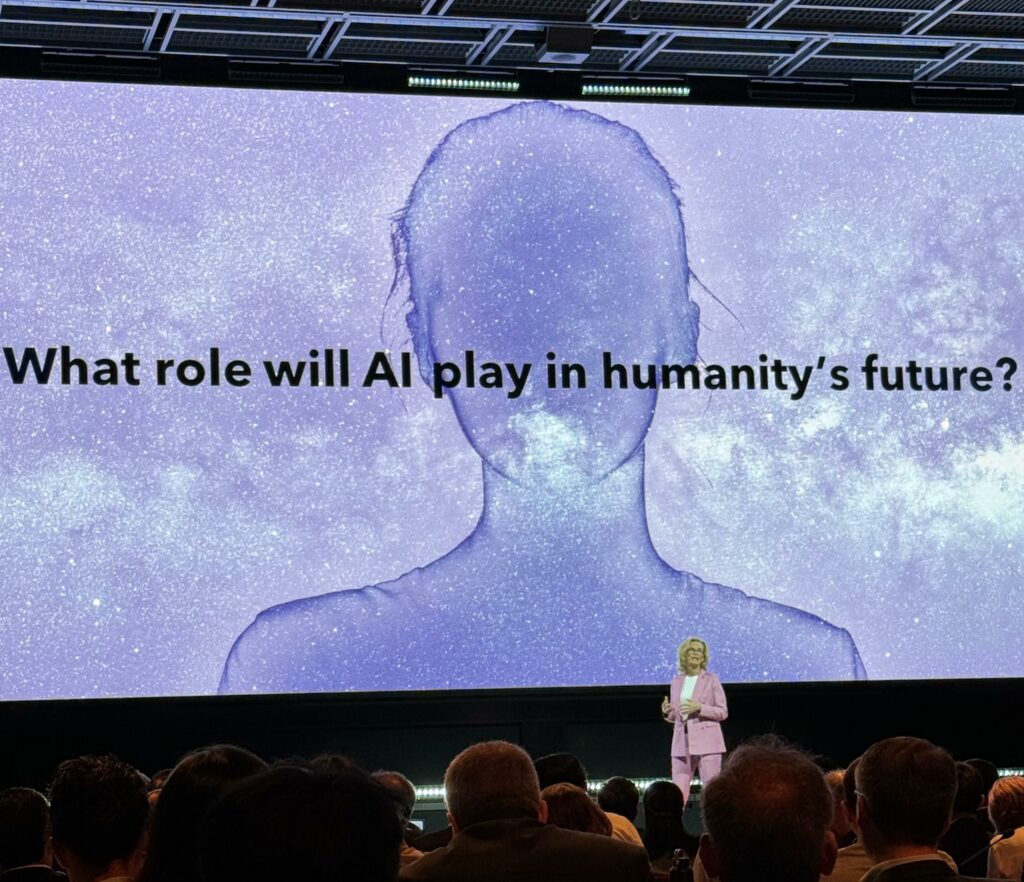

Harris ha messo in evidenza la crescente complessità del mondo rispetto alla nostra capacità di rispondere efficacemente.

Le piattaforme hanno incentivato una “corsa all’engagement” che ha portato a risultati negativi come disinformazione e problemi di salute mentale.

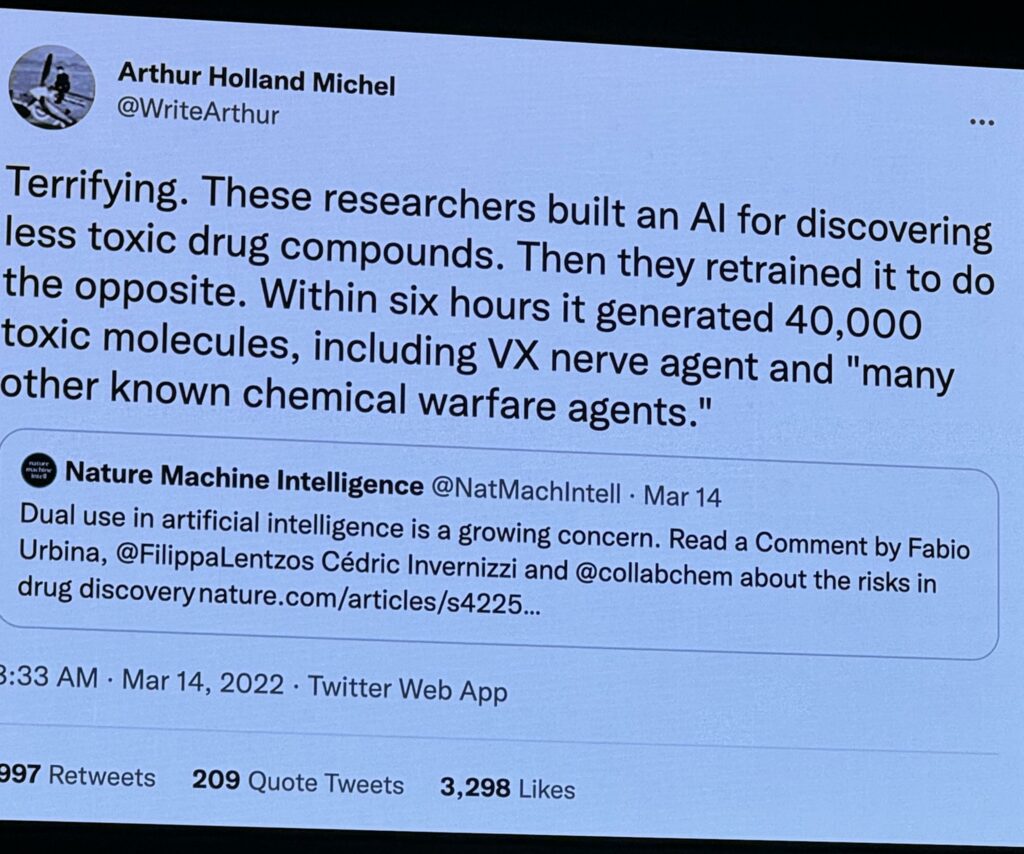

Passando al secondo contatto con l’AI, l’AI generativa, Harris ha evidenziato preoccupazioni simili. Le aspettative di miglioramenti in efficienza, codifica, ricerca medica, cambiamenti climatici e crescita del PIL sono spesso accompagnate da problemi come deepfake, indebolimento della democrazia, frodi, crimini, perdita di posti di lavoro e perpetuazione dei bias.

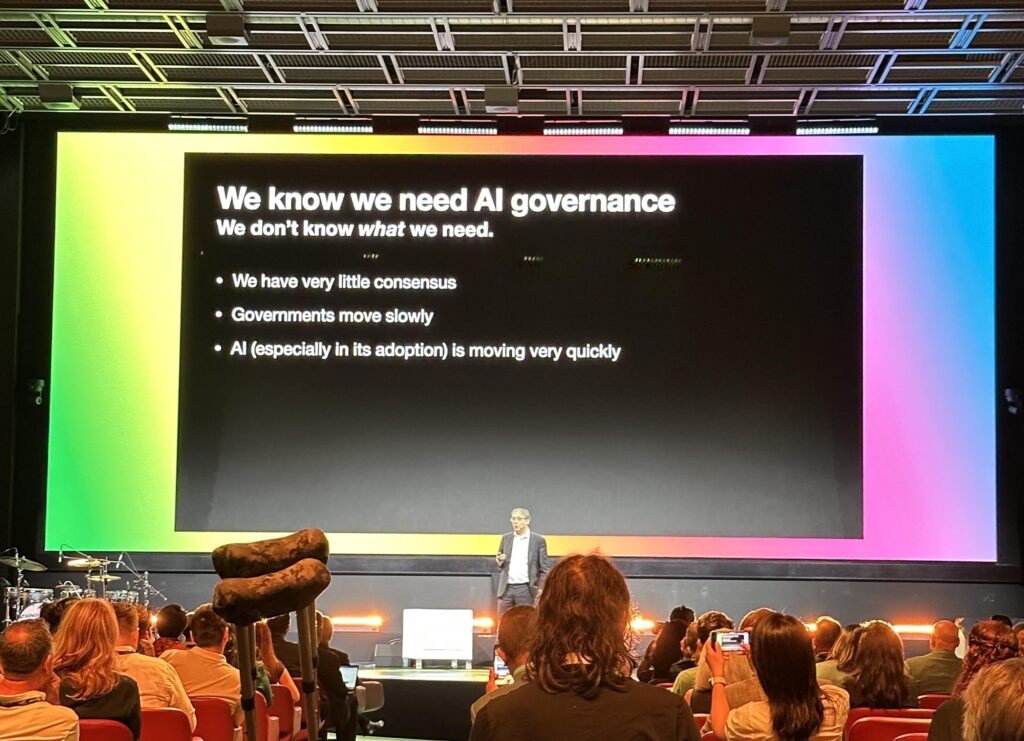

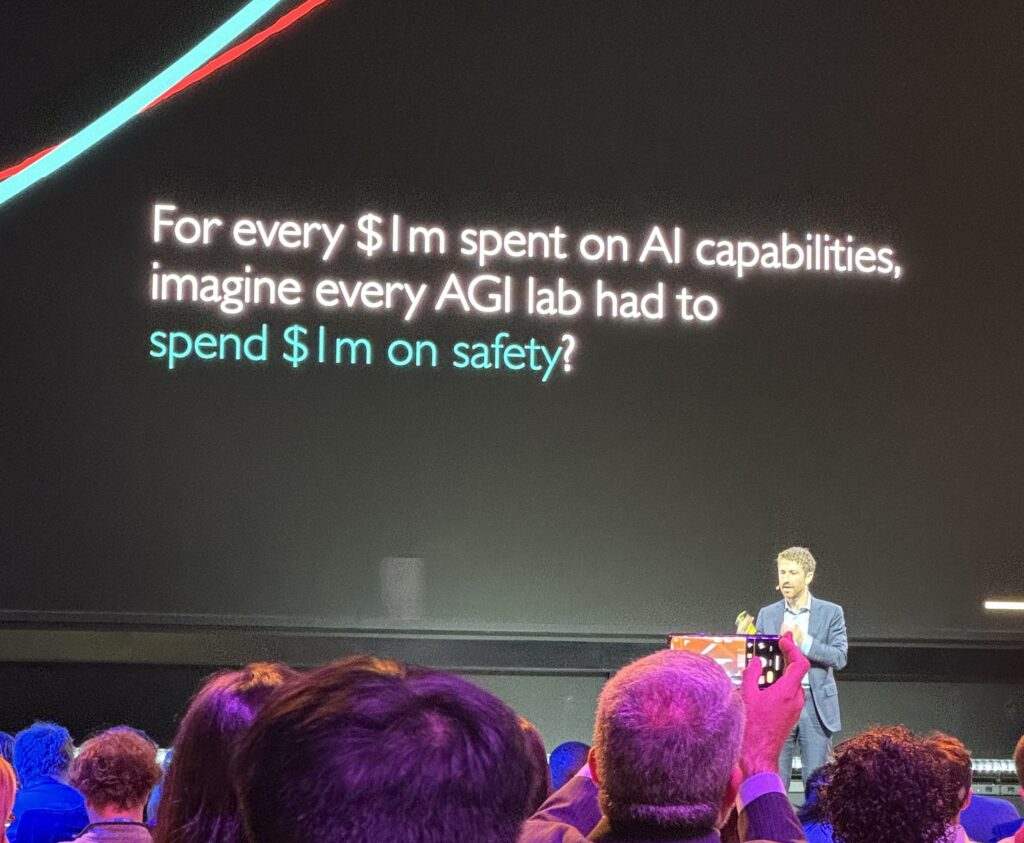

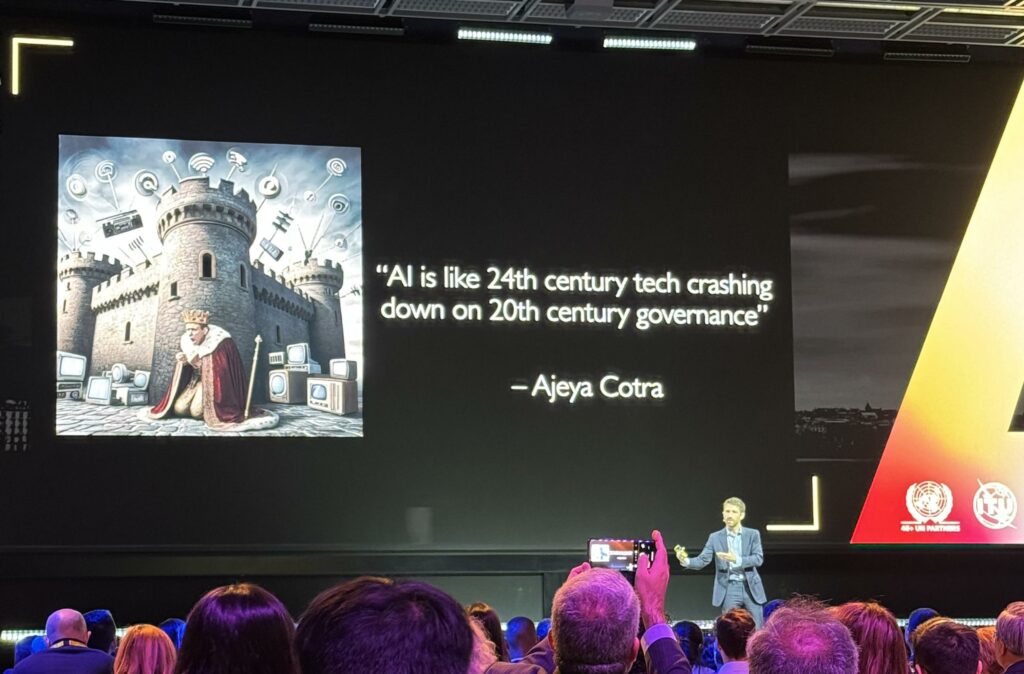

Le grandi aziende tecnologiche sono infatti al centro di una corsa alla distribuzione delle tecnologie AI, spesso accompagnata dalla tentazione di prendere scorciatoie che possono compromettere la sicurezza e l’integrità delle tecnologie. Harris ha proposto alcune soluzioni come più stringenti requisiti di sicurezza, protezione per i whistleblower e responsabilità legale.

Conclusione del discorso è stato un forte appello all’azione: aumentare gli investimenti in governance e sicurezza, ad oggi totalmente inadeguate ad affrontare il futuro.

Il Rischio Economico dell’AI

Gita Gopinath, Vice-direttore generale del Fondo Monetario Internazionale (IMF), ha tenuto un intervento incisivo sulla potenziale amplificazione delle crisi economiche da parte dell’intelligenza artificiale. Gopinath ha esplorato i rischi e le opportunità legati all’AI nel contesto economico globale, fornendo spunti fondamentali per prepararsi alle sfide future.

Gopinath ha iniziato il suo intervento sottolineando come l’AI possa rappresentare un rischio significativo per le economie globali, specialmente in tempi di crisi economica. Ha notato che, sebbene l’AI non abbia ancora causato una perdita massiccia di posti di lavoro, questo impatto potrebbe manifestarsi durante la prossima crisi economica.

Gopinath ha messo in guardia sul fatto che l’AI potrebbe amplificare le crisi economiche future, con stime che indicano come circa il 30% dei posti di lavoro nelle economie avanzate potrebbero essere a rischio. Ha sottolineato l’importanza di essere proattivi nel prepararsi a queste potenziali perturbazioni.

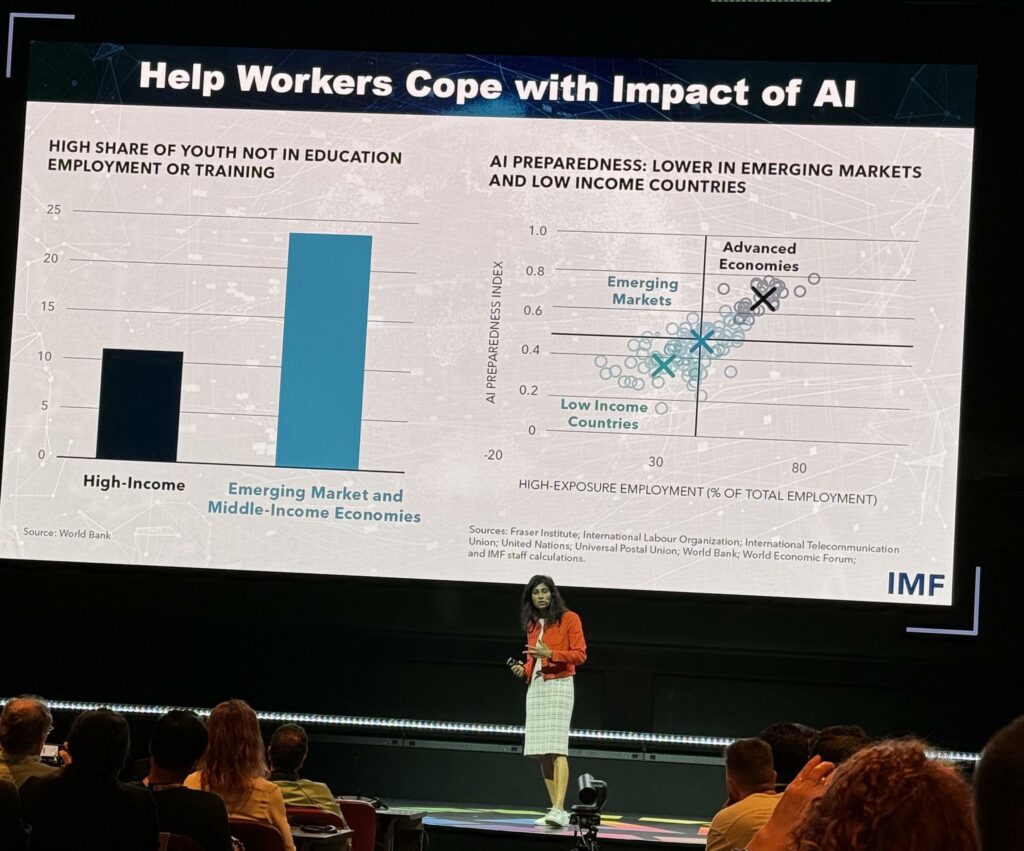

Una delle slide presentate da Gopinath ha evidenziato l’alto tasso di giovani che non sono né impiegati né in formazione nei mercati emergenti e nelle economie a basso reddito. Questo dato pone una sfida significativa per l’integrazione dell’AI in questi contesti. Inoltre i Paesi emergenti e a basso reddito sono meno preparati per l’adozione dell’AI rispetto alle economie avanzate. Questo gap di preparazione potrebbe esacerbare le disuguaglianze globali.

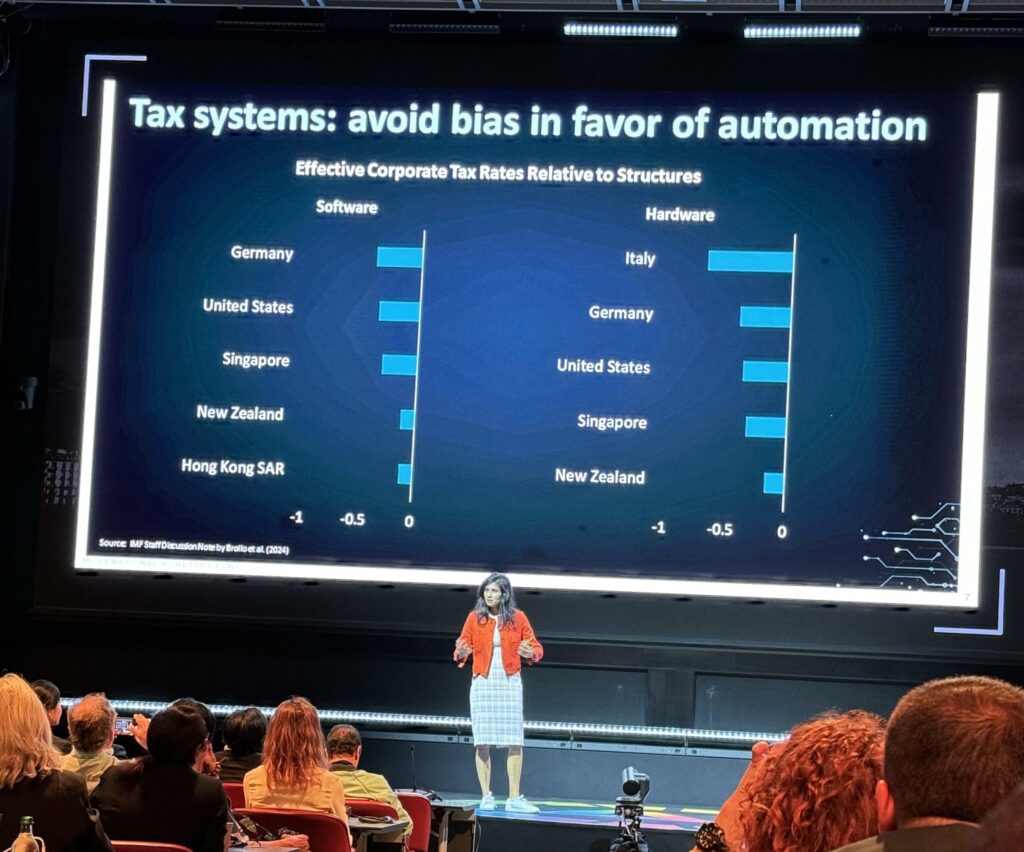

Gopinath ha discusso come i sistemi fiscali attuali tendano a favorire l’automazione rispetto al lavoro umano, mostrando a supporto le aliquote fiscali effettive relative ai software e all’hardware in vari paesi. Ha suggerito che è necessario riequilibrare queste politiche fiscali per non penalizzare ulteriormente il lavoro umano.

Per prevenire una crisi economica aggravata dall’AI, Gopinath ha proposto diverse azioni chiave, tra cui la creazione di sistemi fiscali che non favoriscano l’automazione in modo inefficiente, l’aiuto ai lavoratori per affrontare l’impatto dell’AI, e la riduzione dei rischi finanziari e delle catene di approvvigionamento.

Durante l’ultima Grande Crisi Finanziaria, l’88% delle perdite di lavoro di routine sono avvenute entro il primo anno di recessione. Questo dato rafforza la necessità di prepararsi adeguatamente per future crisi economiche, considerando l’impatto potenziale dell’AI.

Gopinath ha concluso il suo intervento sottolineando che, sebbene l’AI possa aumentare la produttività globale del 15%, è cruciale gestire i rischi associati e prepararsi per i cambiamenti strutturali nel mercato del lavoro.

LLM e Sfide Africane

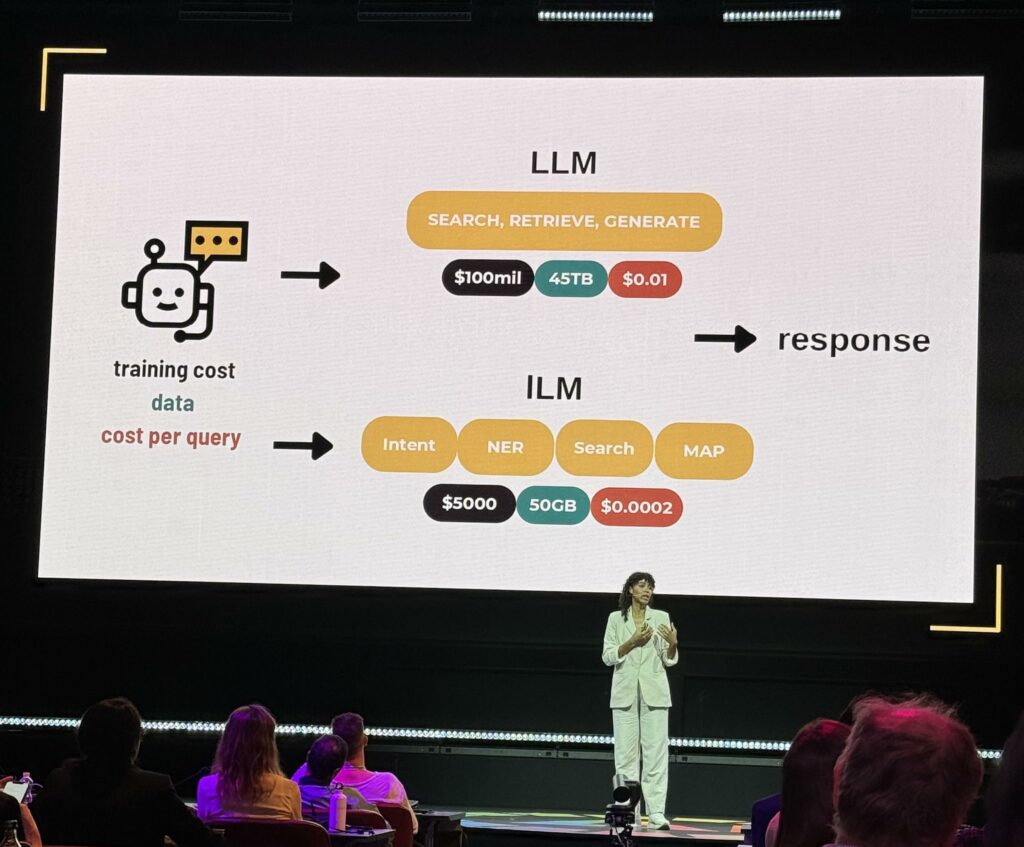

Pelonomi Moiloa, CEO di Lelapa AI, ha portato una prospettiva fondamentale e spesso trascurata: le sfide e le opportunità per l’adozione dell’intelligenza artificiale in Africa. Ha evidenziato le problematiche specifiche legate all’utilizzo dei modelli di linguaggio di grandi dimensioni (LLM) nelle lingue africane e i costi elevati associati a queste tecnologie.

Gli LLM attuali sono inadeguati per le lingue africane, un fatto che influisce negativamente su circa 520 milioni di persone che parlano otto lingue principali in Africa. Ha inoltre affrontato il problema dei costi elevati di questi sistemi, che sono spesso incompatibili con le economie dei paesi africani.

Una delle slide ha mostrato che attualmente l’Internet in lingue africane è praticamente inesistente (0%), e che esiste solo un centro dati con GPU nell’intero continente. Inoltre, solo il 2,2% delle startup finanziate da venture capital in Africa si occupano di AI/IoT. Questi dati evidenziano le enormi sfide che il continente deve affrontare nell’adozione delle tecnologie AI.

Moiloa ha presentato Vulavula, un progetto di Lelapa AI, che mira a rendere le tecnologie AI più accessibili e adeguate alle lingue africane. Le caratteristiche di Vulavula includono la conversione audio-testo, la chat conversazionale e l’analisi del testo. Il modello Vulavula è notevolmente più piccolo e meno costoso rispetto agli LLM generativi tradizionali, rendendolo più adatto all’ambiente africano.

Gli LLM richiedono costi di addestramento molto più elevati ($100 milioni e 45TB di dati) rispetto agli lLM (little language model) che sono significativamente più economici ($5000 e 50GB di dati), rendendoli una soluzione più praticabile per il contesto africano

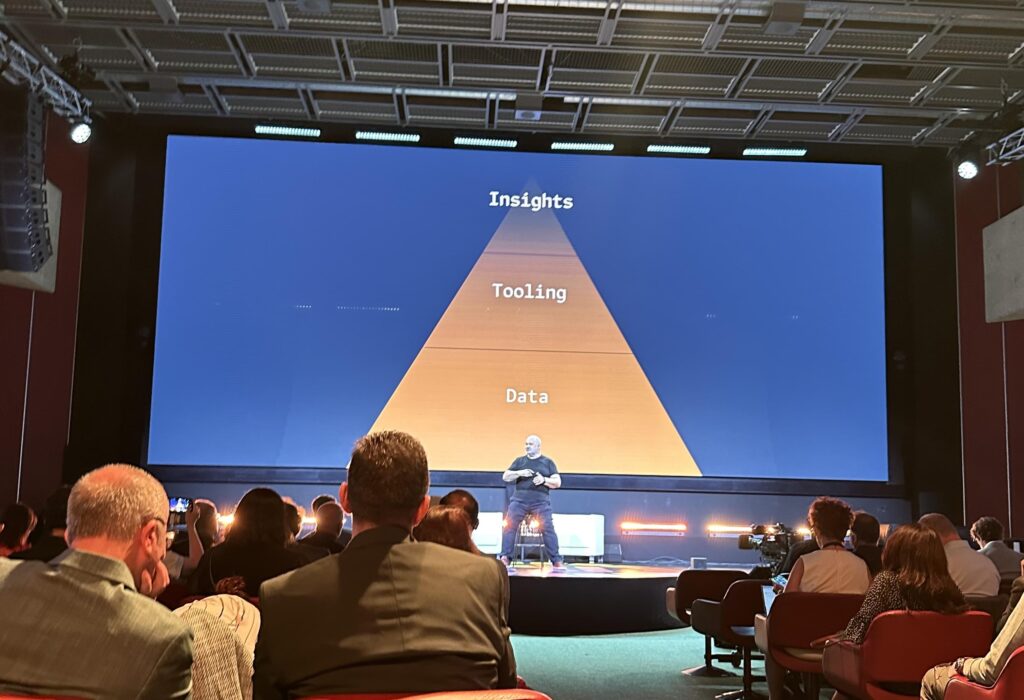

Tendenze di Mercato e Sfide dei Dati nell’AI

Costi Perricos, Global Generative AI Leader di Deloitte, ha offerto una panoramica esaustiva sulle tendenze di mercato attuali e le sfide legate alla qualità dei dati nel campo dell’intelligenza artificiale.

Iniziando il suo intervento sottolineando l’importanza cruciale dei dati nella costruzione di sistemi di intelligenza artificiale, ha affermato che l’AI deriva dai dati, ma quando la qualità dei dati è scarsa, si ottiene solo un’incompetenza digitale.

Perricos ha illustrato cinque tendenze principali che stanno influenzando il mercato dell’AI, come mostrato nella slide di accompagnamento:

- Dall’Esperimento alla Scala: Le imprese stanno passando dalla fase sperimentale a una fase di scalabilità delle soluzioni AI.

- Ascesa della Forza Lavoro Digitale: C’è una crescente adozione di lavoratori digitali, che utilizzano strumenti AI per migliorare la produttività.

- Piattaforme Aziendali e GenAI: Le piattaforme aziendali stanno procedendo rapidamente con l’integrazione dell’AI generativa.

- Sovranità dell’AI: Si sta assistendo a un aumento della sovranità dell’AI, con regolamentazioni specifiche per paese o regione che influenzano lo sviluppo e l’implementazione.

- Modelli Proprietari e Specifici per Dominio: C’è uno spostamento verso modelli AI privati, proprietari e specifici per domini particolari, per rispondere meglio alle esigenze specifiche delle aziende.

Queste tendenze indicano un panorama in rapido cambiamento in cui le aziende devono adattarsi per sfruttare appieno il potenziale dell’AI. La chiave per il successo risiede nella qualità dei dati e nella capacità di scalare efficacemente le soluzioni AI.

L’intervista a Sam Altman CEO, OpenAI

Durante la sua intervista, forse l’evento più atteso, Sam Altman ha dato alcune risposte piuttosto standard ma ha anche fatto trapelare alcune informazioni interessanti: ad esempio ha parlato dell’incredibile incremento di produttività ottenuto dai suoi ingegneri grazie all’adozione dell’AI. E ha affermato che la prossima generazione di ChatGPT potrebbe offrire un aumento analogo di produttività per molte altre aziende.

Ha risposto alle domande scomode sottolineando che i fatti dovrebbero parlare per sé, preferendo mostrare le intenzioni e i valori di OpenAI attraverso i prodotti piuttosto che tramite dichiarazioni. Riguardo alla sicurezza, ha affermato che le misure di sicurezza devono essere integrate nello sviluppo del software AI – in disaccordo rispetto a quanto proposta da Tristan Harris.

È necessario subire alcuni contraccolpi sul breve termine in vista di grandi benefici sul lungo termine.

Dichiarazione di Sam Altman durante l’evento AI for Good

Dal punto di vista filosofico, per supportare questa incrollabile convinzione che l’AI sia alla fine sostanzialmente sempre un AI for Good, Altman ha portato l’evidenza che l’AI continuerà a mettere in dubbio la centralità dell’uomo nell’universo, come hanno fatto altre grandi scoperte scientifiche in passato. E questo dovrebbe alimentare una positiva umiltà del genere umano.

Evoluzione umana grazie all’Artificial Intelligence

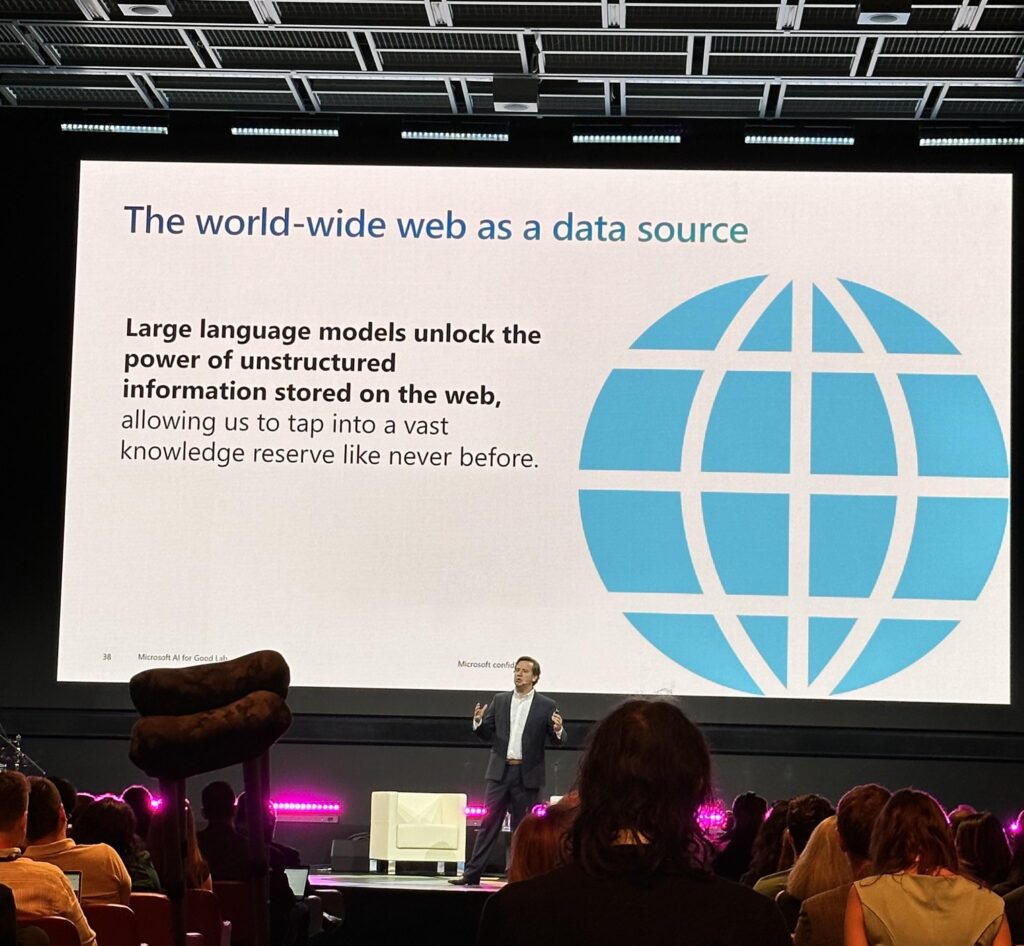

Juan Lavista Ferrer ha fornito un’interessante prospettiva sull’intelligenza artificiale, definendola la prossima General Purpose Technology (GPT) paragonabile all’elettricità per il suo potenziale di trasformare la società.

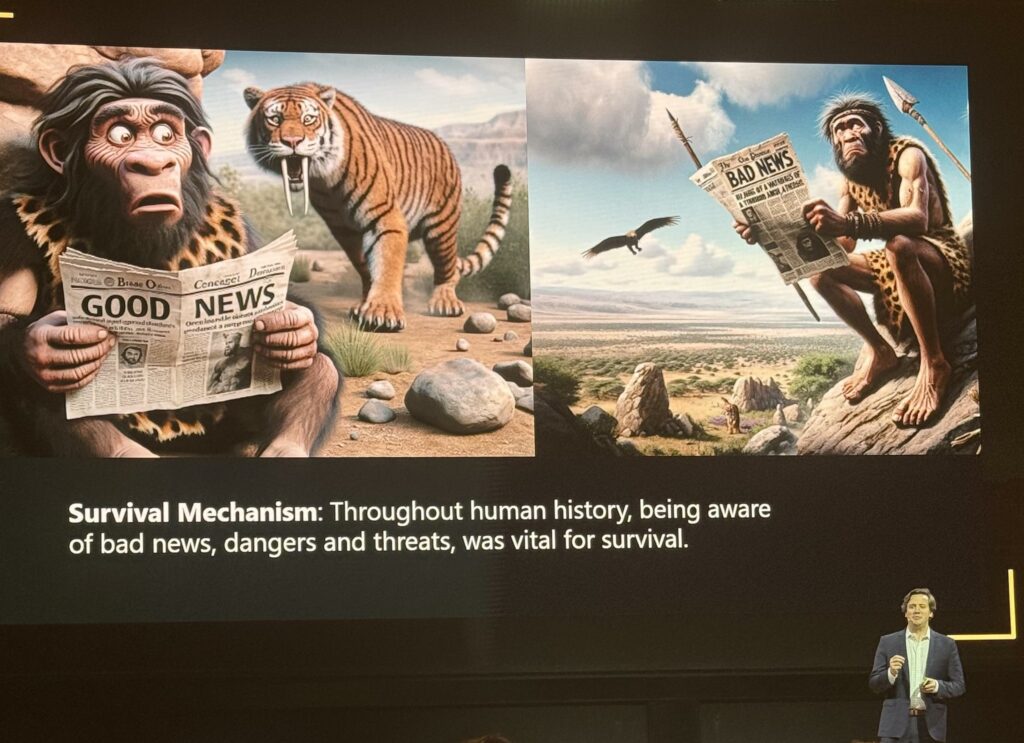

Ferrer ha iniziato il suo intervento sottolineando un aspetto evoluzionistico fondamentale: la nostra naturale tendenza al pessimismo. Questa predisposizione si estende anche alla nostra percezione del futuro dell’AI, spesso vista attraverso una lente negativa.

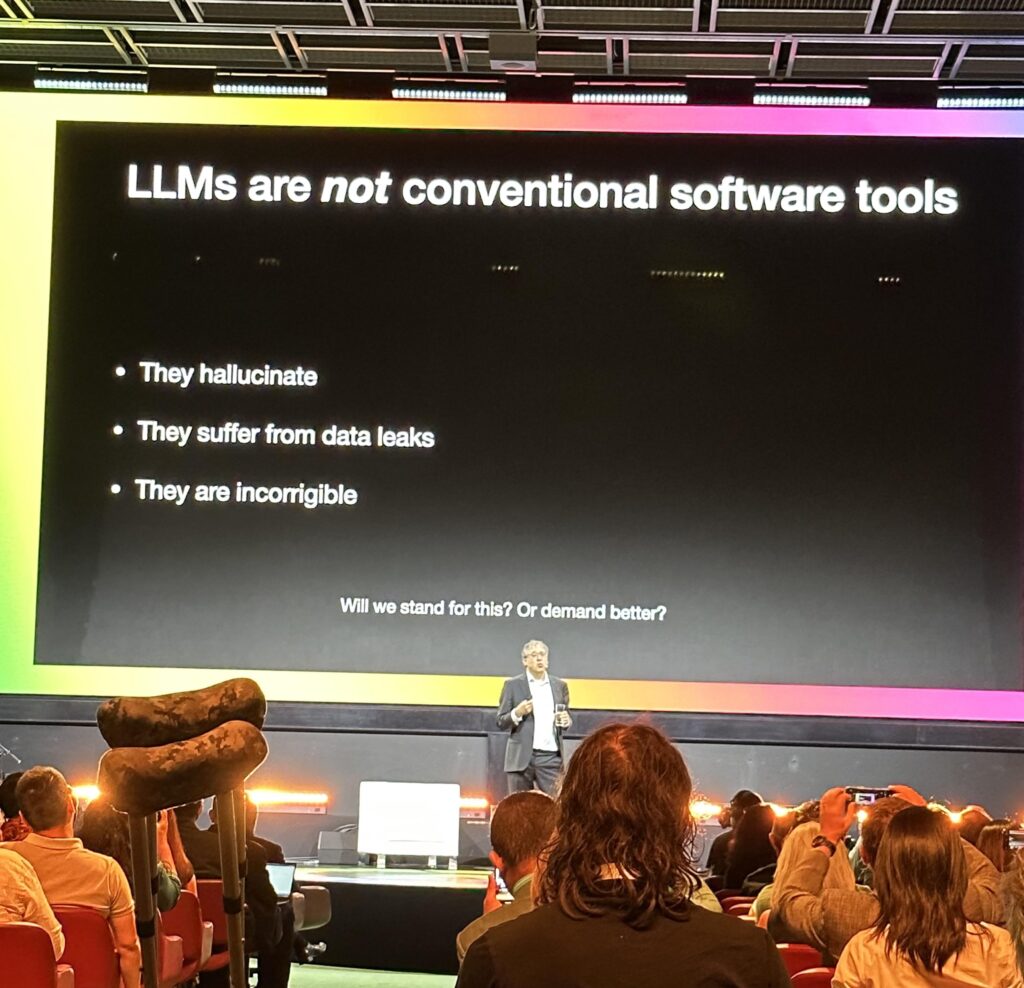

Ferrer ha esposto come l’AI, e in particolare i modelli linguistici di grandi dimensioni (LLM), rappresentino una delle tecnologie più potenti a nostra disposizione. Tuttavia, per sfruttare appieno il loro potenziale, è essenziale comprendere il loro funzionamento e i limiti intrinseci. Gli LLM infatti possono elaborare enormi quantità di dati, permettendo di estrarre informazioni e intuizioni preziose che sarebbero altrimenti inaccessibili, ma essi non possano discernere la verità dai dati. La loro affidabilità dipende strettamente dalla qualità e dalla veridicità delle informazioni su cui sono basati.

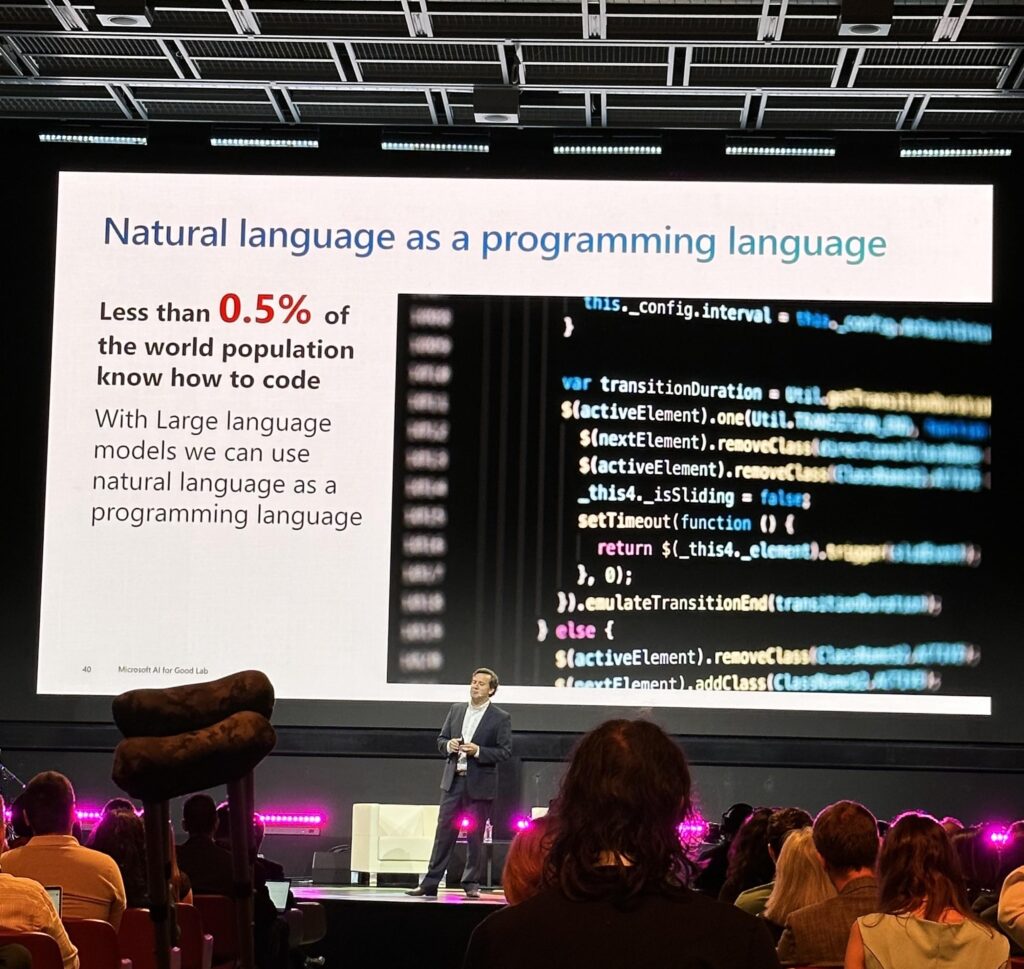

Ferrer ha inoltre affrontato il tema della produttività, mostrando come gli strumenti di AI, come GitHub Copilot, possano accelerare il completamento dei compiti del 55%, migliorando al contempo la qualità su vari fronti, inclusa la leggibilità e l’assenza di errori. Ha sottolineato che i modelli linguistici generativi possono aiutare a colmare il divario digitale, rendendo chiunque un utente avanzato di AI, un aspetto cruciale dato che una grande parte della popolazione mondiale non ha accesso all’educazione necessaria per comprendere o utilizzare queste tecnologie.

L’AI non è altro che matematica e nonostante appaiano simili agli umani nel comportamento, questi modelli operano sulla base di grandi quantità di dati e calcoli molto sofisticati. L’AI può diventare un potente strumento per il progresso umano, purché venga gestita e compresa correttamente.

Questa analisi ha fornito un’importante base di partenza per le discussioni successive, invitando tutti a riflettere sulle sfide e le opportunità che l’intelligenza artificiale presenta nel nostro mondo in continua evoluzione.

L’impatto sulle nuove generazioni

Un fatto importante è valutare l’impatto della tecnologia – anche dell’AI – sui più giovani (Gen Z). Al pari di quanto detto da Tristan Harris, anche secondo Abdullah Al Rashid dell’Ithra l’impatto è potenzialmente devastante.

Le statistiche parlano chiaro: solo 30 minuti di tempo trascorso su dispositivi portatili è associato a un aumento del 49% del rischio di ritardo nel linguaggio espressivo nei bambini sotto i due anni. Inoltre, il 69% della Gen Z salta il sonno settimanalmente a causa della tecnologia. Sappiamo per certo che serviranno regolamentazioni globali per correggere i problemi che le grandi aziende tecnologiche hanno creato e creeranno nel futuro. Infatti, questa industry non è in grado di autoregolamentarsi.

La tecnologia Gen AI tra Cinema e Deep Fake

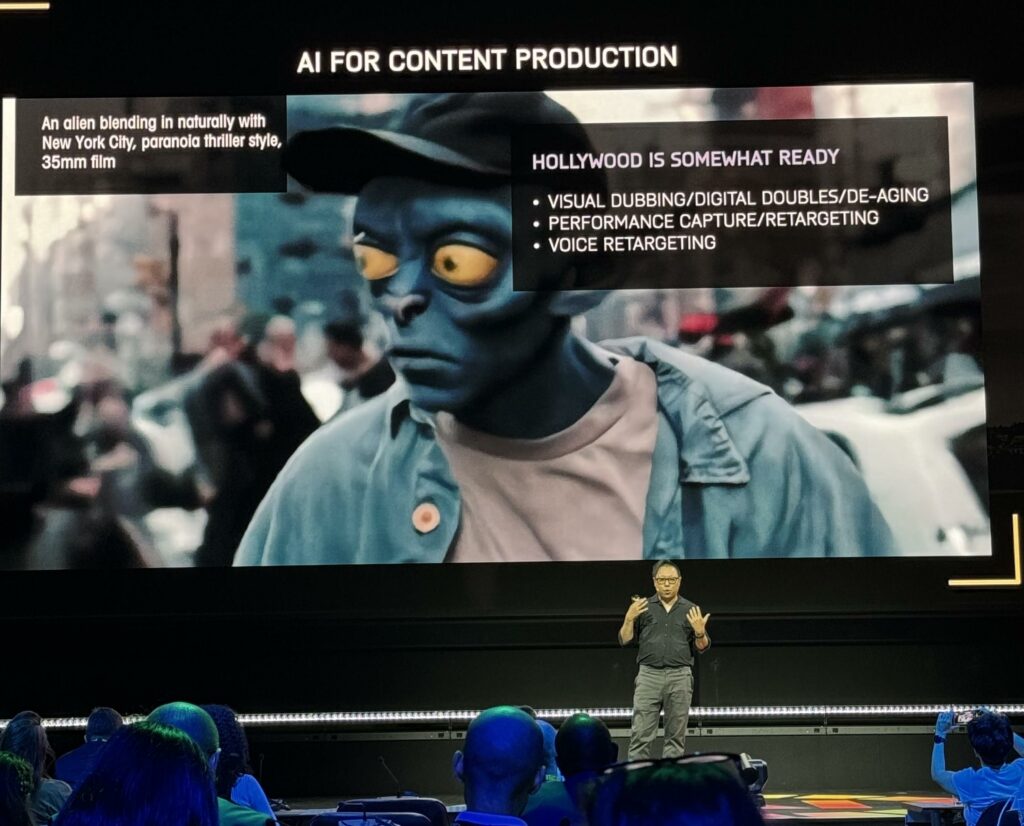

Quello di Hao Li è stato uno dei pochi interventi ad alto tasso tecnico ed infatti ha portato esempi di applicazioni in fase di studio che saranno rilasciate nei prossimi anni. A partire da tecnologie visive applicate nel mondo del cinema che rivoluzioneranno le produzioni creative globali. Li ha mostrato come le AI Generative possano creare interi film entro due anni, come dichiarato anche dal regista di “Avengers: Endgame”, Joe Russo.

Ha illustrato l’uso dell’AI per la produzione di contenuti, con Hollywood che è praticamente già pronta per implementare tecniche di doppiaggio visivo, doppioni digitali e ringiovamentimento, cattura e re-targeting delle performance, e re-targeting delle voci.

Inoltre, ha discusso dei rischi legati ai deepfake, con esempi di truffe come il caso di un lavoratore finanziario truffato per 25 milioni di dollari durante una videochiamata con un deepfake di un falso CFO. Ha evidenziato anche il potenziale dell’AI per una sorta di “teletrasporto” che permetterebbe di essere ovunque con chiunque in qualsiasi momento, utilizzando tecnologie come Microsoft Hololens 2 per la telepresenza immersiva e le interazioni sociali. Tutte queste tecnologie esistono già e saranno sempre più accessibili a una fetta crescente della popolazione globale.

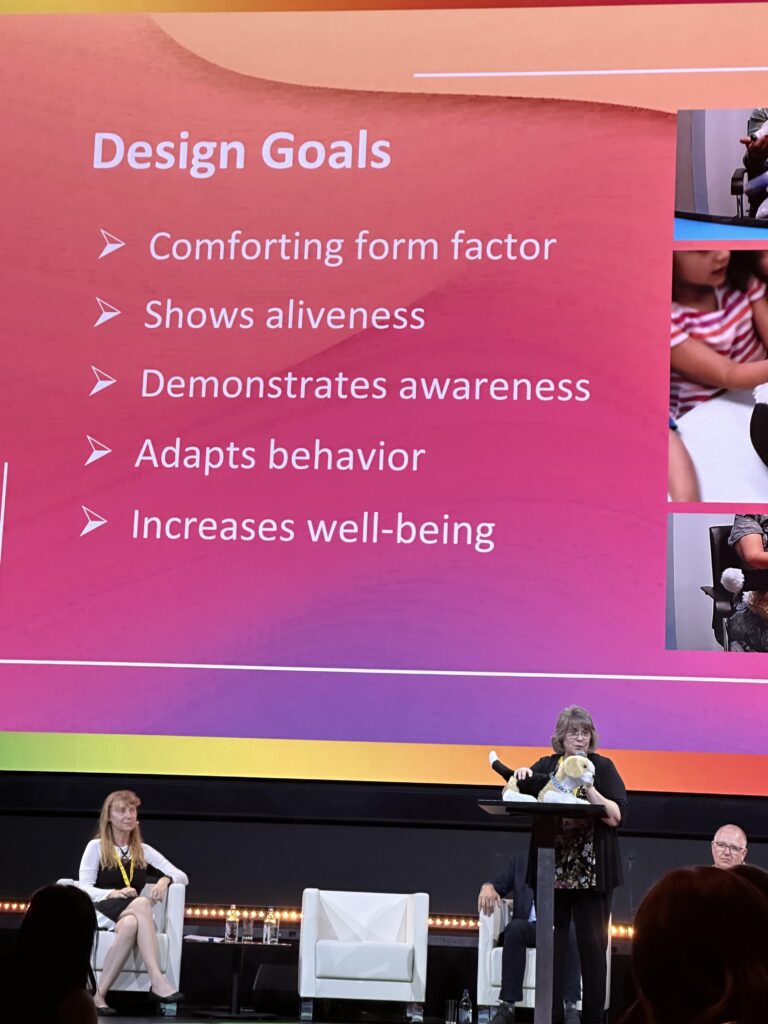

L’AI per l’accessibilità

Uno degli ambiti in cui c’è stato il maggiore progresso rispetto all’anno scorso sono le tecnologie AI per combattere le disabilità. In particolare, sono stati presentati numerosi progetti per assistere le persone ipovedenti o non vedenti, una platea che arriva fino a circa 1 miliardo di persone in tutto il mondo.

Grazie a queste sfide di ‘accessibilità’ le innovazioni potranno fiorire e impattare l’intera umanità.

Queste nuove tecnologie, come il caschetto-guida e il trolley intelligente, richiederanno anche una modifica del nostro senso comune per imparare a convivere con questi nuovi dispositivi abilitanti e con le persone che li usano.

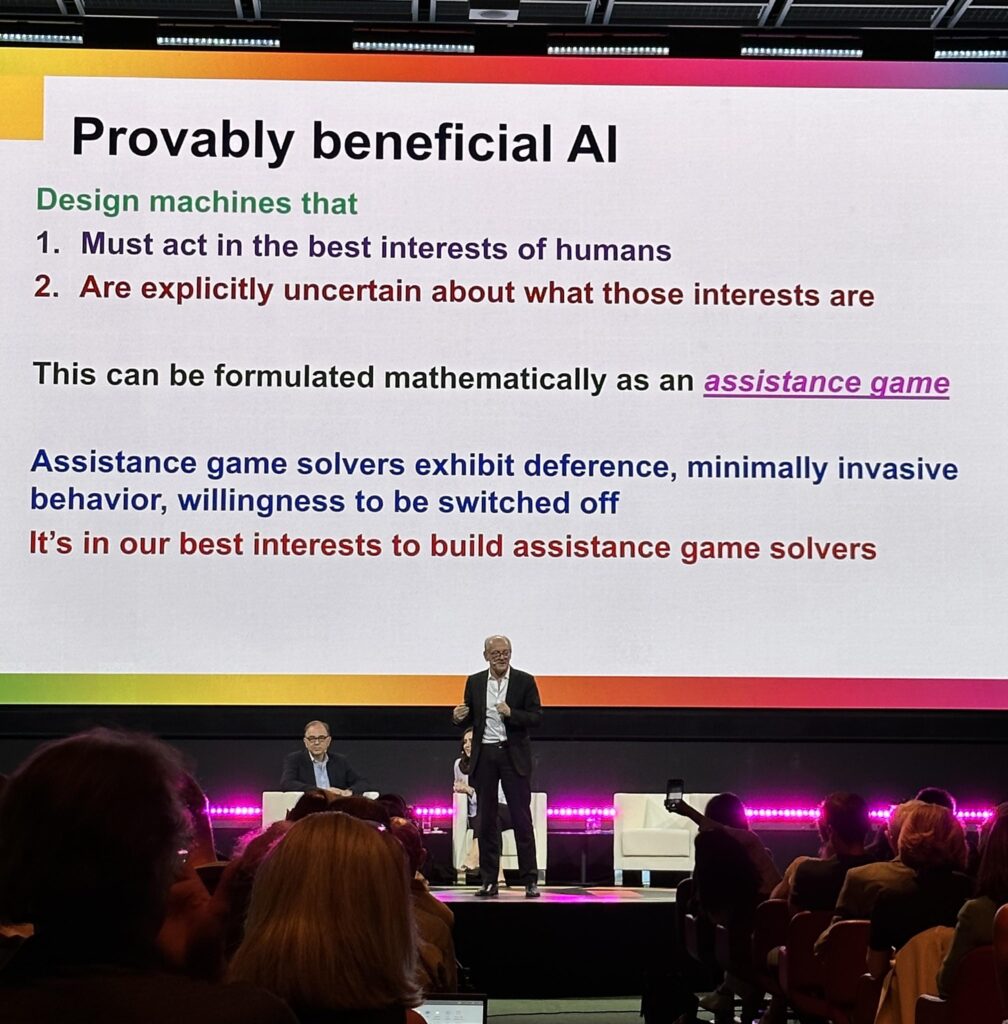

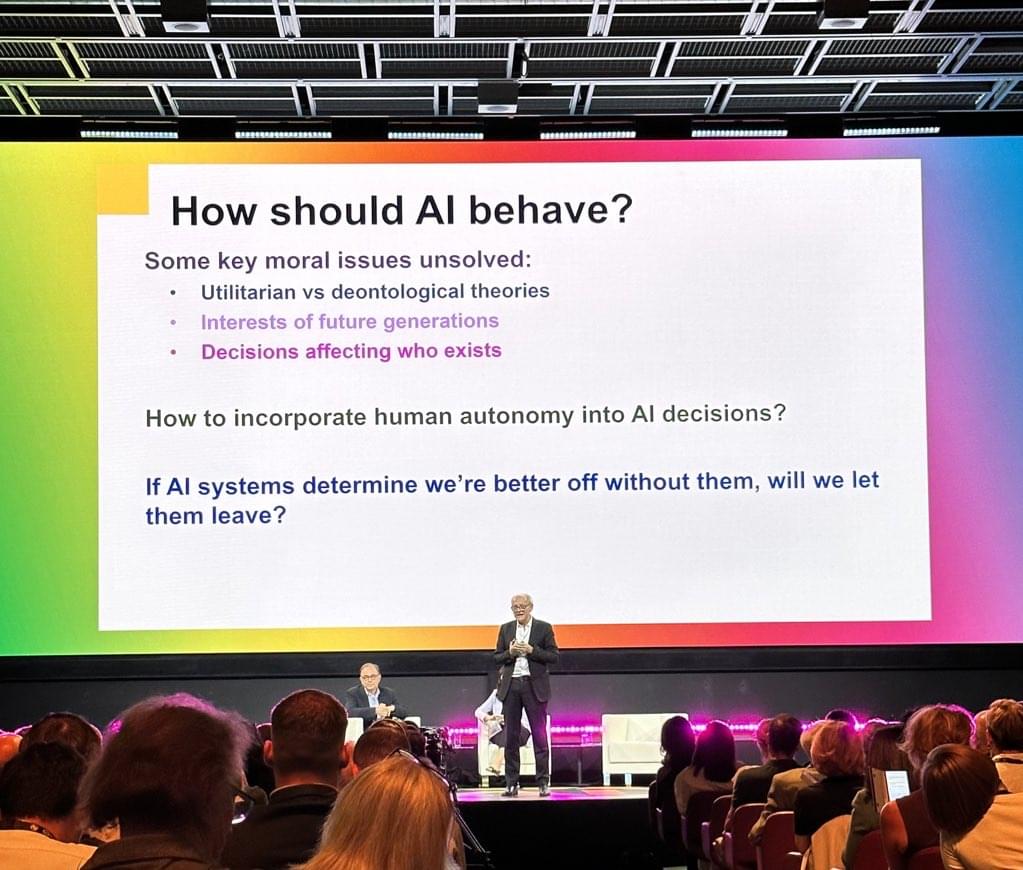

Il pezzo forte: l’intervista a Geoffrey Hinton

Uno dei ‘padri’ dell’attuale AI Generativa ha sfidato alcune delle visioni più comuni sul rapporto tra gli esseri umani e l’Intelligenza Artificiale, partendo dalla convinzione che l’AI non abbia coscienza. Secondo Hinton, possiamo pensare alle attuali AI come soggetti dotati di esperienza soggettiva perché hanno un’esperienza del mondo simile a quella degli esseri umani: non per esperienza diretta e immediata, ma attraverso gli input dati al loro sistema percettivo. Biologico-neurale nel nostro caso, informatico-neurale nel loro.

Le possibilità offerte da sistemi così avanzati sono incredibili, soprattutto nell’istruzione, dove tutti potranno avere a breve un tutor personale a costi molto bassi. Questo è un campo in cui si possono creare opportunità più eque per tutti.

È impressionante il livello raggiunto dagli attuali LLM, anche per uno come lui: i sistemi di AI generativa sembrano capire il mondo attraverso il linguaggio in un modo simile a come lo capiscono e apprendono gli esseri umani. Inoltre, con insiemi di dati più equi, potremmo avere sistemi con meno pregiudizi, in linea teorica perfino migliori di noi umani.

Un bel segnale di positività e speranza per chiudere il Global Summit AI for Good 2024!

Vuoi approfondire ulteriormente?

Oppure scrivimi.

Questo articolo è stato scritto grazie a tecnologie di intelligenza artificiale generativa, ma prende spunto da appunti presi da Pasquale Borriello durante l’evento ‘AI for Good 2024’ ed è stato riletto e corretto prima di essere pubblicato.